ChatGPT получил новую модель GPT-4o: что умеет нейросеть и где ее попробовать

13 мая OpenAI провела презентацию, на которой представила новую улучшенную модель GPT-4o.

GPT-4 Omni, или просто GPT-4o, одновременно работает с текстом, картинками, видео и аудио. Раньше в ChatGPT для каждого формата действовали разные нейросетевые модели — это влияло на скорость ответов и качество результатов. Получается, новое поколение фактически переизобрело то, что зовется мультимодальностью в современных нейросетях.

В презентации отдельно сделали акцент на возможностях GPT-4o в качестве голосового помощника. Нейросеть эмоционально разговаривает, использует разные интонации и даже обладает харизмой — разработчики неоднократно отсылались к фильму «Она» . Расскажу, что показали на презентации, какие есть сценарии использования модели и где ее можно попробовать.

Что вы узнаете

Что может GPT-4o

Вот чем GPT-4o отличается от предыдущих моделей.

🗣️ Голосовой ассистент распознает речь и поддерживает диалоги в реальном времени. Взаимодействие происходит более естественно, чем раньше: время отклика на аудиозапросы составляет в среднем 0,3 секунды, что сопоставимо со скоростью реакции человека.

Нейросеть говорит не роботизированным монотонным голосом, а смеется, выражает эмоции, меняет интонации и даже поет.

📹 Распознавание видео и изображений. GPT-4o лучше анализирует и интерпретирует визуальные данные. Она распознает объекты, действия и сцены в видео. Например, модель смогла транскрибировать ролик и выделить разных спикеров с записи встречи. Раньше нейросеть работала только со статичными изображениями: картинками, скриншотами, фото.

📈 Мультимодальность. Модель принимает на входе и генерирует на выходе любые комбинации текста, аудио и изображений. Она работает по принципу end-to-end, что означает, что все виды информации обрабатываются одной нейросетью.

📄 Обработка текста соответствует уровню GPT-4 Turbo при работе на английском. На других языках работу существенно улучшили.

🗂️ Увеличенное контекстное окно. Нейросети можно «скармливать» большие объемы информации. На презентации она поддерживала разговор в течение семи минут, а в примерах на сайте OpenAI сделала краткий пересказ 40-минутного видео.

🌅 Улучшенная работа с изображениями. Нейросеть создает текст практически без артефактов, а также консистентных персонажей в разных позах и 3D-модели.

Как можно использовать модель — полезные демосценарии

OpenAI показала на презентации несколько вариантов использования возможностей новой модели. Вот некоторые из них.

Общаться как с другом. Нейросеть в прямом эфире посмотрела на сотрудника OpenAI и поняла, что он в приподнятом настроении. А потом спросила, чему он так радуется, и смутилась, когда тот сказал, что проводит презентацию ее возможностей.

Учить языки. Нейросети можно показать разные объекты и попросить переводить на другой язык. Например, в деморолике GPT-4o показали фрукты, ручки и плюшевую игрушку — она перевела все верно.

Переводить в реальном времени. Нейросеть попросили помочь в разговоре италоговорящей девушки и англоговорящего парня. Когда GPT-4o слышала итальянскую речь, сразу переводила на английский, и наоборот.

Оценить образ. Сотрудник OpenAI спросил, достаточно ли он хорошо выглядит для похода на собеседование, — GPT-4o порекомендовала ему причесаться. Когда тот надел шляпу, нейросеть сказала, что он выглядит несерьезно, и посоветовала ее снять.

Провести игру «Камень, ножницы, бумага». Два человека играли, а GPT-4o выступала комментатором: распознавала, что они показывают, озвучивала все действия и объявила победителя.

Обучать математике. Нейросеть попросили помочь с тригонометрическим уравнением, но не давать ответ сразу, а научить подростка решать его самостоятельно. GPT-4o провела по шагам, исправила ошибки и привела к верному ответу.

Петь. Сотрудница OpenAI попросила нейросеть сочинить песню про Сан-Франциско и спеть ее несколькими голосами одновременно. GPT-4o исполнила песню а капелла: генерировать инструментальную музыку она не может.

Как получить доступ к GPT-4o и будет ли она бесплатной

Пока нейросеть доступна только с текстовыми и визуальными возможностями. Когда появится поддержка аудио и видео, неизвестно.

Разработчикам GPT-4o доступна по API. Она работает в два раза быстрее и стоит в два раза дешевле, чем GPT-4 Turbo. Компания также пересмотрела токенизацию : например, при генерации на русском языке количество токенов уменьшилось в 1,7 раза.

Некоторым платным подписчикам ChatGPT тоже предоставили доступ к нейросети. В течение нескольких недель GPT-4o появится у всех.

Бесплатным пользователям ChatGPT дадут доступ к GPT-4o в ближайшее время с ограничением по количеству сообщений.

На сайте Chatbot Arena текстовые возможности GPT-4o доступны бесплатно, но с ограничениями по количеству запросов.

В наушниках Nothing появится интеграция с голосовым ассистентом в ChatGPT в конце мая.

Что еще изменится для пользователей ChatGPT

После презентации OpenAI объявила еще о нескольких изменениях.

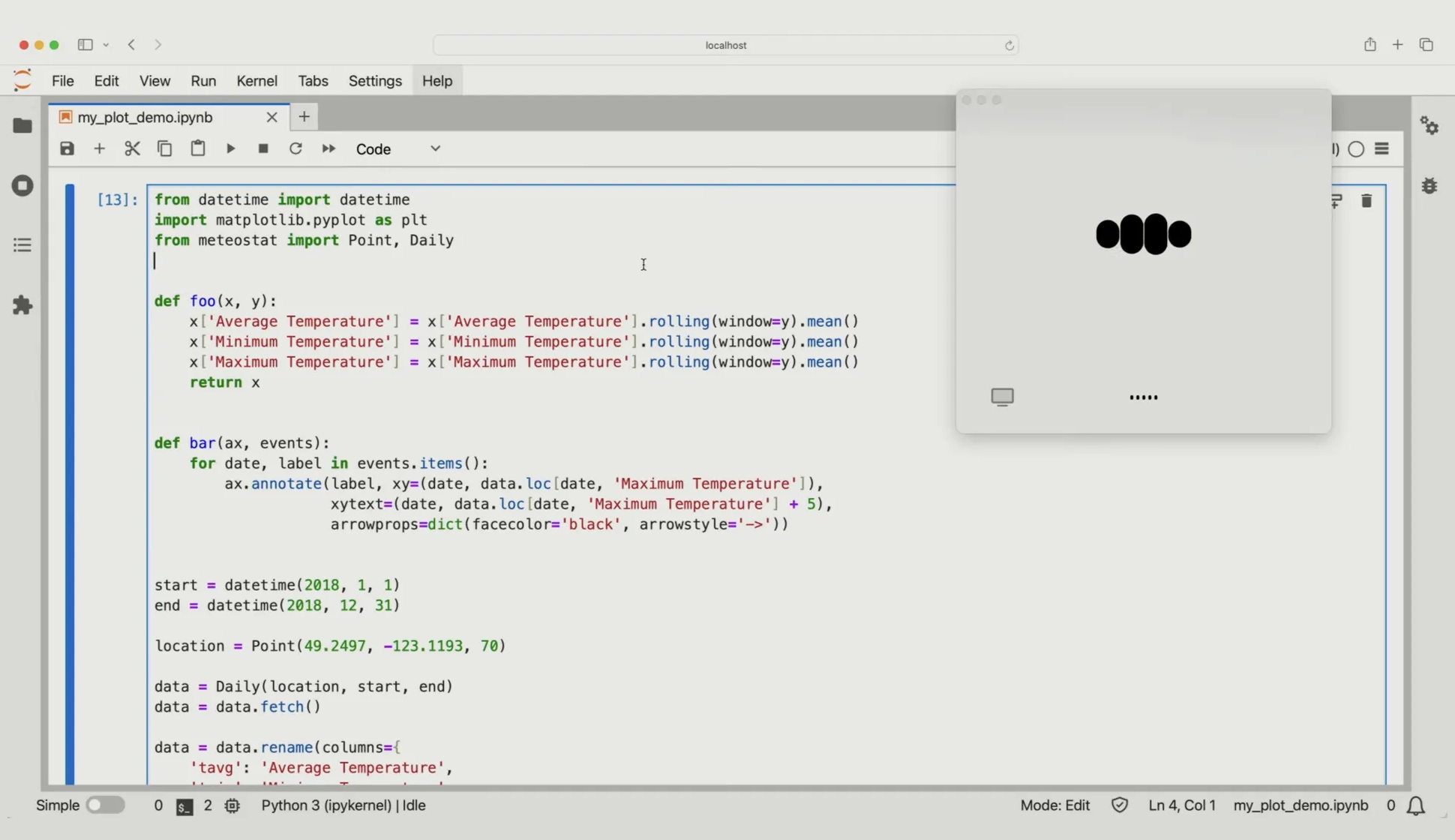

Для macOS вышло десктопное приложение. Оно позволяет открывать ChatGPT в небольшом окне рядом с другой программой и задавать вопросы о том, что находится на экране. ChatGPT будет отвечать, основываясь на том, что видит. OpenAI планирует выпустить версию для Windows позже в 2024 году. В будущем приложение также получит поддержку аудио.

Пока приложением могут пользоваться только некоторые платные подписчики ChatGPT.

Часть платных функций «переедет» в бесплатный ChatGPT. Модель GPT-4o c возможностями GPT-4, веб-поиск, анализ данных и магазин ботов GPTs станут доступны бесплатно всем пользователям ChatGPT в течение следующих недель. Раньше ради этого нужно было покупать подписку.

Редизайн сайта. ChatGPT получил более дружелюбный и разговорный интерфейс.

Мы рассказываем разные истории о популярной культуре и тех, кто ее создает. Подписывайтесь на наш телеграм: @t_technocult