Runway Gen-2: как пользоваться нейросетью для генерации видео

ИИ генерирует уже не только картинки, но и видеоролики — тоже по текстовому запросу.

Пока в этой нише больше других преуспела компания Runway, которая запустила уже второе поколение своей нейросети для создания видео. Достаточно описать сцену, чтобы получить короткий фрагмент, при желании такие можно смонтировать в полноценный ИИ-ролик. Раньше сервис был на стадии закрытой бета-версии, но 7 июня он стал доступен для всех.

Бесплатные генерации в Runway Gen-2 ограничены, но позволяют оценить возможности нейросети. Расскажем, как пользоваться нейросетью и что там можно сгенерировать.

Как воспользоваться Runway Gen-2

Runway Gen-2 доступен на сайте или в приложении для iOS. На сайт можно зайти без VPN, а приложение есть в российском регионе.

Вот как воспользоваться сервисом:

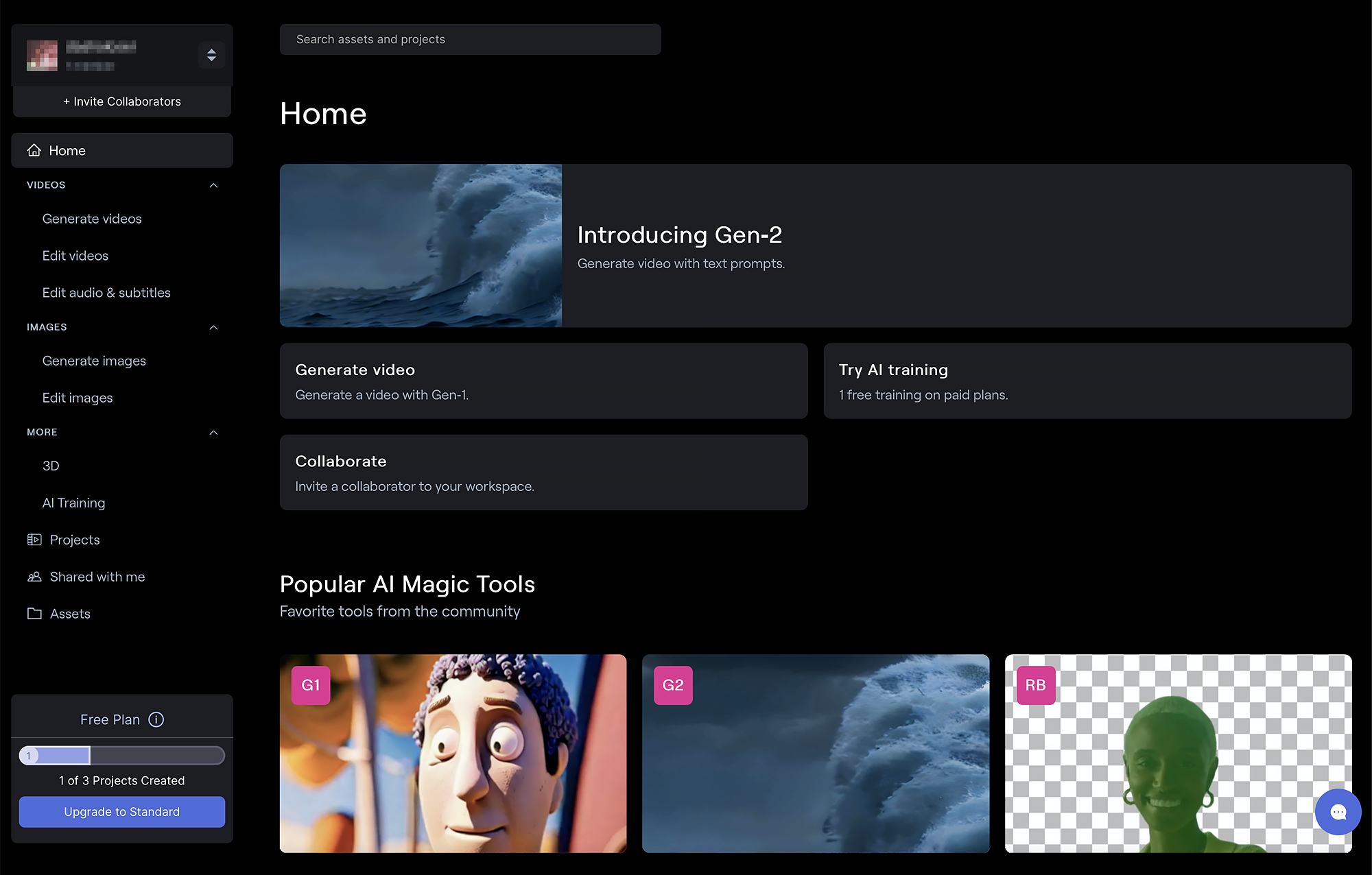

- Зарегистрируйтесь на сайте Runway или войдите через аккаунт Google или Apple.

- Нажмите Introducing Gen-2 либо найдите опцию Gen-2: Text-to-video во вкладке AI Magic Tools.

- Введите запрос на английском языке и дождитесь генерации.

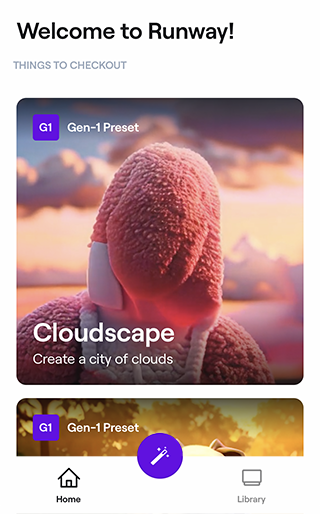

Как воспользоваться сервисом в приложении:

- Нажмите на фиолетовую кнопку с волшебной палочкой на главной странице приложения.

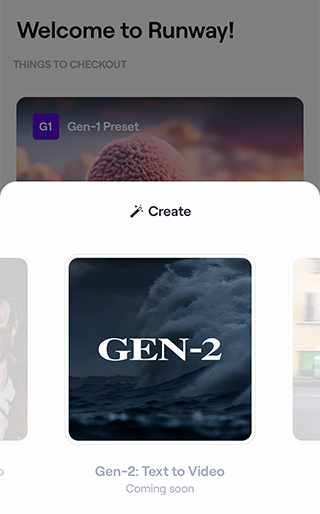

- В появившемся окне выберите Gen-2 и зарегистрируйтесь.

- Введите запрос на английском языке и дождитесь генерации.

Какие ограничения у бесплатной версии и покупать ли премиум

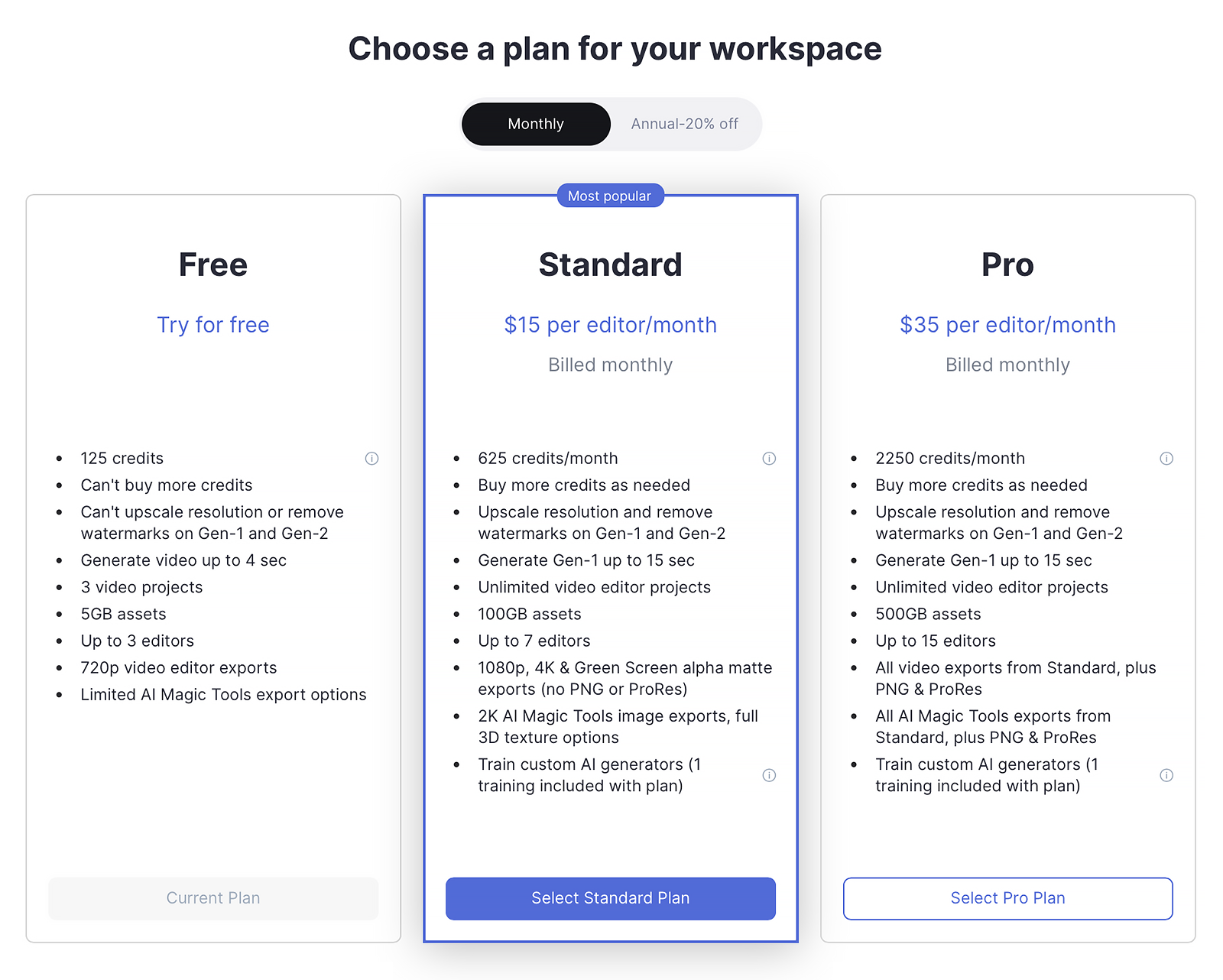

По запросу Gen-2 генерирует не полный ролик, а короткую четырехсекундную сцену. После регистрации на один бесплатный аккаунт дают 105 секунд генерации. Этого хватит примерно на 26 попыток. Даже если вам не понравится результат, он засчитается как использованная попытка. Бесплатно можно сделать еще три проекта: то есть, три раза объединить короткие ролики в один.

После окончания пробного периода каждый месяц вам дают еще 25 секунд — это шесть новых попыток. Покупать дополнительные кредиты на бесплатный аккаунт нельзя. Больше секунд генерации можно получить по подписке. Оплатить ее российской картой не получится.

💰 Стандартная подписка стоит 15 $ (1252 ₽) в месяц и дает возможность делать безлимитные проекты, докупать кредиты, повышать разрешение, убирать вотермарку и один раз дообучить нейросеть на своих данных. В план входит почти две минуты генерации видео — ненамного больше, чем в бесплатной версии, зато каждый месяц.

👑 Про-подписка стоит 32 $ (2671 ₽) и дает то же самое, что и стандартная, а также семь с половиной минут генерации ежемесячно. Этого должно хватить, чтобы сделать полноценный короткометражный ролик.

Как генерировать видео в Runway Gen-2

По простым запросам в Gen-2 очень сложно получить красивые ролики, которые встречаются в соцсетях. Рассказываем, как не потратить бесплатные секунды впустую.

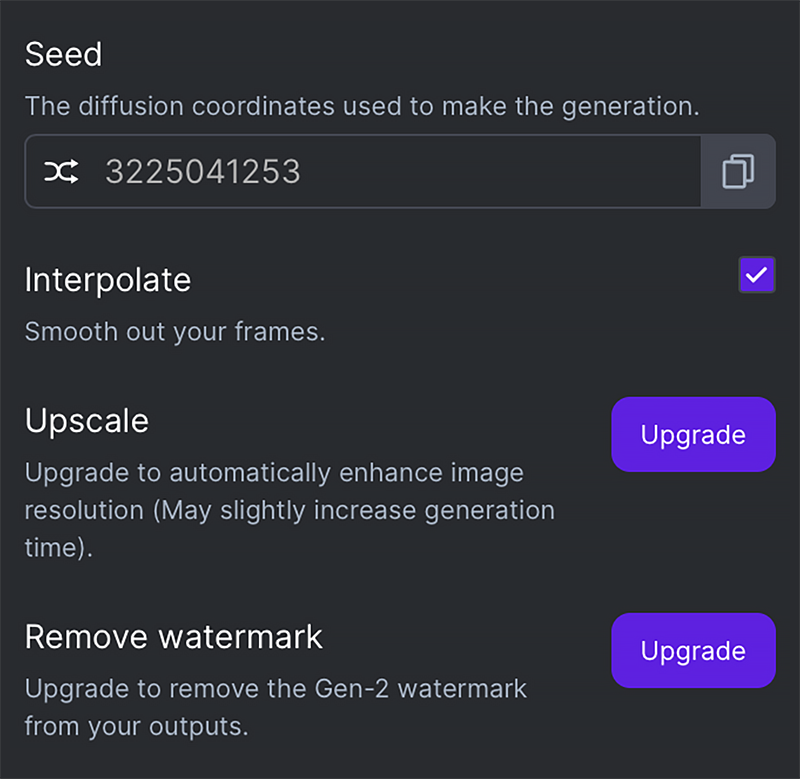

🤖 Включите интерполяцию. Под полем, куда нужно вводить текстовый запрос, есть кнопка с настройками: там можно выставить сид, увеличить разрешения изображения и убрать вотермарку. Поставьте галочку возле интерполяции — эта настройка сгладит картинку.

🧬 Пишите запрос по формуле. В Gen-2 можно написать что угодно, но результаты не всегда будут хорошими. В соцсетях предполагают, что нейросеть в основном обучена на стоковых видео, поэтому умеет генерировать действия и объекты, которые в них встречаются.

К примеру, если не указать в запросе действие, то получится статичная картинка, а если написать «кунг-фу-драка», выйдет месиво из тел. Имена режиссеров и названия фильмов Gen-2 тоже не распознает, поэтому к желаемой стилистике придется стремиться вручную.

Блогер Theoretically Media вывел формулу, которая дает лучшие результаты. Запрос стоит формулировать так: стиль — жанр — кадр — объект — действие — окружение — освещение. Если нам нужно сгенерировать сцену из киберпанк-фильма, где едет машина, то запрос будет выглядеть так: Cinematic action, cyberpunk film, car driving, city, night lighting.

Вот какие параметры можно указать в запросе:

- Стиль: cinematic action (кино), animation (анимация), black and white (черно-белый фильм).

- Жанр: sci-fi film (научно-фантастическое кино), cyberpunk film (киберпанковый фильм), horror film (фильм ужасов), ad (реклама).

- Кадр: wide angle (широкий угол), medium shot (средний план), close up shot (крупный план), extreme close up shot (очень крупный план), long shot (общий план).

- Объект: a woman with red hair (женщина с красными волосами), a man in a blue suit (мужчина в синем костюме), a dog (собака), a mountain (гора), a boat (лодка).

- Действие: walking (идет), running (бежит), talking (говорит), swimming (плавает), jumping (прыгает).

- Окружение: beach (пляж), city (город), New York (Нью-Йорк), the moon (луна), volcano (вулкан).

- Освещение: sunset (рассвет), sunrise (закат), day (день), night (ночь), horror film lighting (освещение как в хорроре), sci-fi lighting (освещение как в научной фантастике).

📎 Закрепите сид. Сид — стартовая точка, из которой нейросеть затем формирует изображение. По умолчанию стоит случайный параметр из десяти цифр. Если использовать один и тот же сид с разными запросами, будут получаться схожие по стилю результаты. А если использовать один сид с одинаковым запросом, будут генерироваться идентичные видео.

Сиды нужно использовать, чтобы сгенерировать несколько коротких роликов в общей стилистике, а потом объединить их в один. Для этого после первой генерации кликните на настройки и поставьте замочек возле номера сида. Не забывайте снимать замочек, когда генерируете ролики в другой тематике.

🖼️ Генерируйте на основе картинки. Gen-2 сложно заставить генерировать детали или сложные действия, например, человека на скейтборде или крупный план лица. Чтобы обойти это ограничение, можно использовать изображение для референса. Для этого добавьте картинку справа от текстового поля. Не забудьте написать сам текстовый запрос: что вы хотите, чтобы делал персонаж с вашей картинки.

Gen-2 не принимает изображения, защищенные авторским правом, поэтому генерировать видео на основе кадров из фильмов или сериалов не получится. Но картинки со стоков или фотографии использовать можно. Часто пользователи генерируют арты в Midjourney, а потом анимируют их в Gen-2, чтобы избежать нарушений.

🛼 Готовьтесь рероллить. Часто будет получаться не то, что вы представляли.

Gen-2 страдает от проблем ранних картиночных нейросетей: не справляется с пальцами и глазами, отрывает конечности, не понимает сложные запросы, генерирует лишние объекты. Чтобы добиться хорошего результата, нужно запастись терпением.

Что генерируют в Gen-2

Бета-тестеры уже успели оценить возможности Gen-2 и делятся результатами в соцсетях. Многие дополнительно накладывают звук и вставки между сценами. Мы собрали лучшие примеры сгенерированных в нейросети роликов.

Мы постим кружочки, красивые карточки и новости о технологиях и поп-культуре в нашем телеграм-канале. Подписывайтесь, там классно: @t_technocult