Как пользоваться нейросетью Stable Diffusion без навыков программирования

Stable Diffusion — одна из самых продвинутых нейросетей для генерации изображений.

Программа от группы Stability AI вышла в публичный доступ в августе 2022 года. Нейросеть может качественно генерировать изображения на основе текстового запроса, дорисовывать наброски и переделывать картинки-референсы на свой лад. Все это бесплатно, а открытый исходный код позволяет установить Stable Diffusion на свой компьютер и использовать собственные вычислительные мощности.

У этого есть и обратная сторона: не все устройства подходят под системные требования, а для использования полной версии Stable Diffusion нужно разбираться в установке программы. Энтузиасты уже разработали на базе сети сайты, приложения, боты. Разобрались, чем интересна Stable Diffusion и как попробовать нейросеть.

Что вы узнаете

🎨 Что можно делать в Stable Diffusion

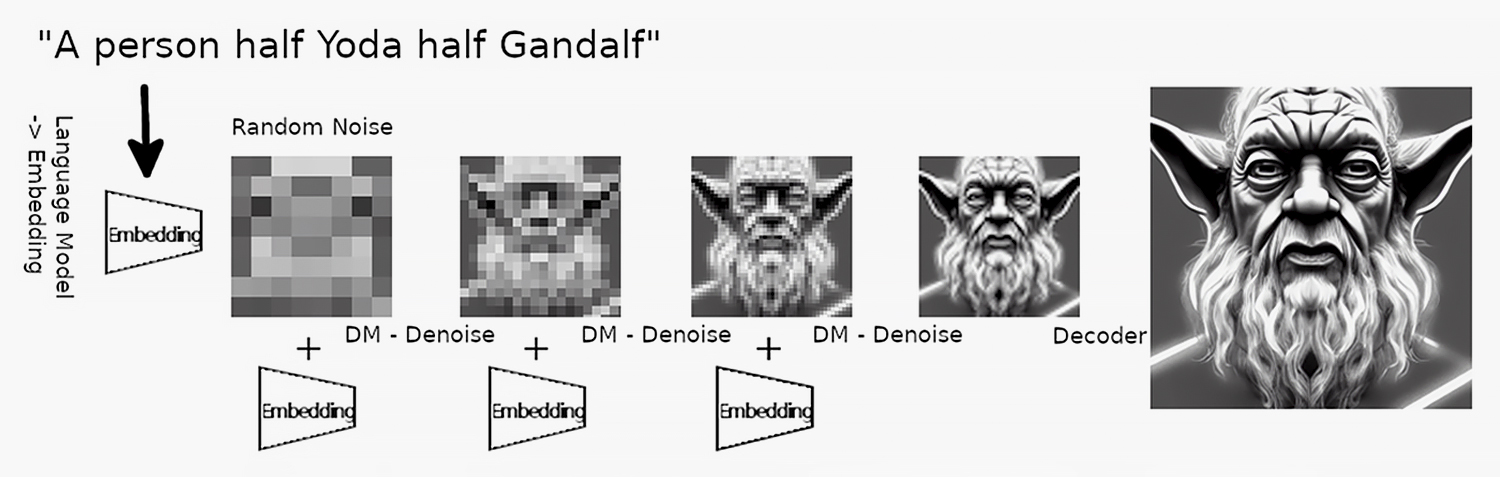

Генерировать стандартные картинки по описанию. Нейросеть использует модель скрытой диффузии. Ее обучали на базе данных, где каждое изображение связано с описанием. После этого Stable Diffusion изучила ассоциации о том, где пиксели должны находиться по отношению друг к другу. Из такого «шума» пикселей нейросеть постепенно генерирует картинку.

Стандартные модели нейросетей вроде Dall-E 3 и Midjourney работают на серверах компаний, поэтому у пользователя меньше контроля над процессом. Часть запросов не проходит из-за цензуры или правовых ограничений, а некоторые функции у конкурентов даже отсутствуют. Например, в Stable Diffusion возможно генерировать по контуру фотографии или дообучать модель на собственном датасете.

Заимствовать стили реальных художников. Stable Diffusion знает стили всех художников — от времен ренессанса до современных авторов концепт-артов в видеоиграх. Можно генерировать картинку одновременно в стиле Ван Гога и NFT-артиста Beeple.

Правда, из этого возникает проблема: нейросеть обучали на множестве артов, не спросив разрешения у авторов. Это касается как известных художников, так и любительских работ с сайтов Pinterest и DeviantArt, которые обнаружили при анализе набора данных. Даже появился сайт Have I Been Trained, в котором можно узнать, использовались ли ваши работы для обучения Stable Diffusion или Midjourney.

Например, пользователи Stable Diffusion чаще всего генерировали картинки в стиле польского художника Грега Рутковски, создателя фэнтези-артов для видеоигр. Его имя сильно улучшает качество изображений и добавляет им эпичности. Если попытаться поискать работы Рутковски, чаще появляются сгенерированные картинки в его стиле, а не оригиналы.

Создавать ассеты для игр. Пользователи сети смогли интегрировать нейросеть в игровой движок Unreal Engine. Это позволяет генерировать внутриигровые предметы по описанию и сразу же помещать их в игровое пространство.

Следующий уровень такой интеграции — это генерация локации в виртуальной реальности в реальном времени с помощью Stable Diffusion и других нейросетей одновременно.

Делать визуальные проекты. Пользователи научились не просто делать отдельные картинки, а создавать покадровую анимацию и совмещать сгенерированные изображения в полноценные ролики.

Stable Diffusion даже используют при создании рекламы. Например, Coca-Cola выпустила ролик, в котором картины известных художников анимированы с помощью нейросети.

Заменять объекты и дорисовывать фон. У Stable Diffusion есть функции Inpainting и Outpainting, которыми не могут похвастаться другие нейросети. С помощью Inpainting можно заменить любой объект на изображении на сгенерированный нейросетью — например, поменять кота на собаку.

Функция Outpainting позволяет бесконечно дорисовывать готовое изображение и генерировать фон вокруг готовой картинки. Например, пользователь Reddit дорисовал платье героине картины «Девушка с жемчужной сережкой».

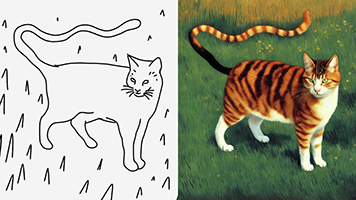

Дорисовывать наброски. В Stable Diffusion можно сделать небольшой набросок, а нейросеть сама дорисует детали и фон. Так родители превращают детские рисунки в фотореалистичные картины, а художники пользуются функцией, чтобы сократить время создания арта.

Есть более сложный сценарий — отрисовывать отдельные детали изображения с помощью нейросети, а потом соединять их с помощью инструментов «Фотошопа». Для удобства Stable Diffusion уже интегрировали в программу.

👨🎨 Как самому попробовать Stable Diffusion

Разработчики Stable Diffusion придерживаются принципов открытости: исходный код нейросети опубликован на «Гитхабе». При этом не обязательно уметь программировать, чтобы его запустить. Огромное сообщество энтузиастов придумало более простые способы.

Есть два основных способа пользоваться Stable Diffusion, вот они.

Через сайт или приложение. Плюсы: не требует знания кода или доступа к вычислительным мощностям — генерация происходит на сторонних ресурсах, от вас требуется только составить запрос. Минусы: нередко онлайн-версии Stable Diffusion ограничены по функциям, разрешению картинок и качеству генерации. Часть возможностей платная.

Через программу с графическим интерфейсом. Гораздо меньше ограничений, результаты выходят намного качественнее. Интерфейсы различаются удобством использования и установки. Минусы: нужно обладать компьютером, который подходит под системные требования.

При выборе Stable Diffusion нужно обращать внимание на версию. Помимо официальных моделей от Stability AI существует множество неофициальных, которые настраивали и дообучали сами пользователи. Вот пять основных официальных версий:

- Stable Diffusion 1.5. После выхода этой версии Stable Diffusion стали пользоваться массово: она гибкая и генерирует качественные картинки. Обучена на большом датасете, включая NSFW-контент. Это все еще самая популярная версия в сообществе: она требует меньше всего производительных мощностей компьютера. На ее основе часто дообучают свои модели.

- Stable Diffusion 2.1. Самый непопулярный официальный релиз. Она генерирует меньше артефактов, чем 1.5, лучше попадает в запрос, умеет создавать текст. Но из датасета удален весь NSFW-контент, поэтому она так и не стала успешна в сообществе.

- Stable Diffusion XL. Вышла летом 2023 года. Генерирует в разрешении 1024 × 1024, создает текст, лучше работает с композицией. На ее основе появилось много пользовательских моделей. Модель хуже генерирует NSFW-контент по сравнению с версией 1.5. А еще ее нельзя дообучать на слабых компьютерах.

- Stable Cascade. Вышла в феврале 2024 года. Нейросеть генерирует картинки быстрее и справляется с текстом еще лучше, чем SDXL. Но сейчас Stability AI разрешает использовать новую модель только по подписке. Веса и код доступны для исследовательских целей бесплатно.

- Stable Diffusion 3. Самая новая версия, где сильно изменили архитектуру, поэтому она гораздо лучше понимает запросы. По словам разработчиков, модель использует новый тип диффузионного трансформера, который похож на нейросеть для генерации видео Sora от OpenAI. Пока что нейросеть доступна лишь через список ожидания.

Подробно расскажу о том, как запустить Stable Diffusion через сайты, приложения и программы.

📱 Как генерировать в Stable Diffusion через сайт или приложение

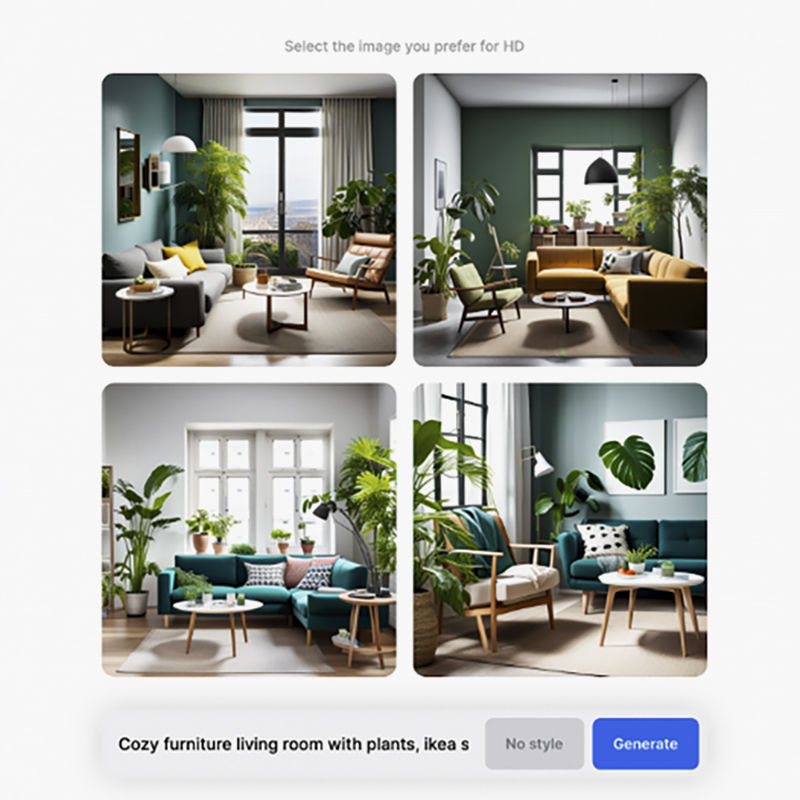

ClipDrop. Официальный сайт Stability AI со Stable Diffusion XL. Генерирует четыре варианта, у одного из которых можно увеличить разрешение. На сайте также можно выбрать один из готовых стилей: аниме, оригами, цифровой арт, комикс и другие.

Stability AI использует этот сайт, чтобы собирать фидбэк от пользователей, когда они выбирают лучшую картинку из четырех. Таким же образом фибдек получают в Midjourney при тестировании новых версий.

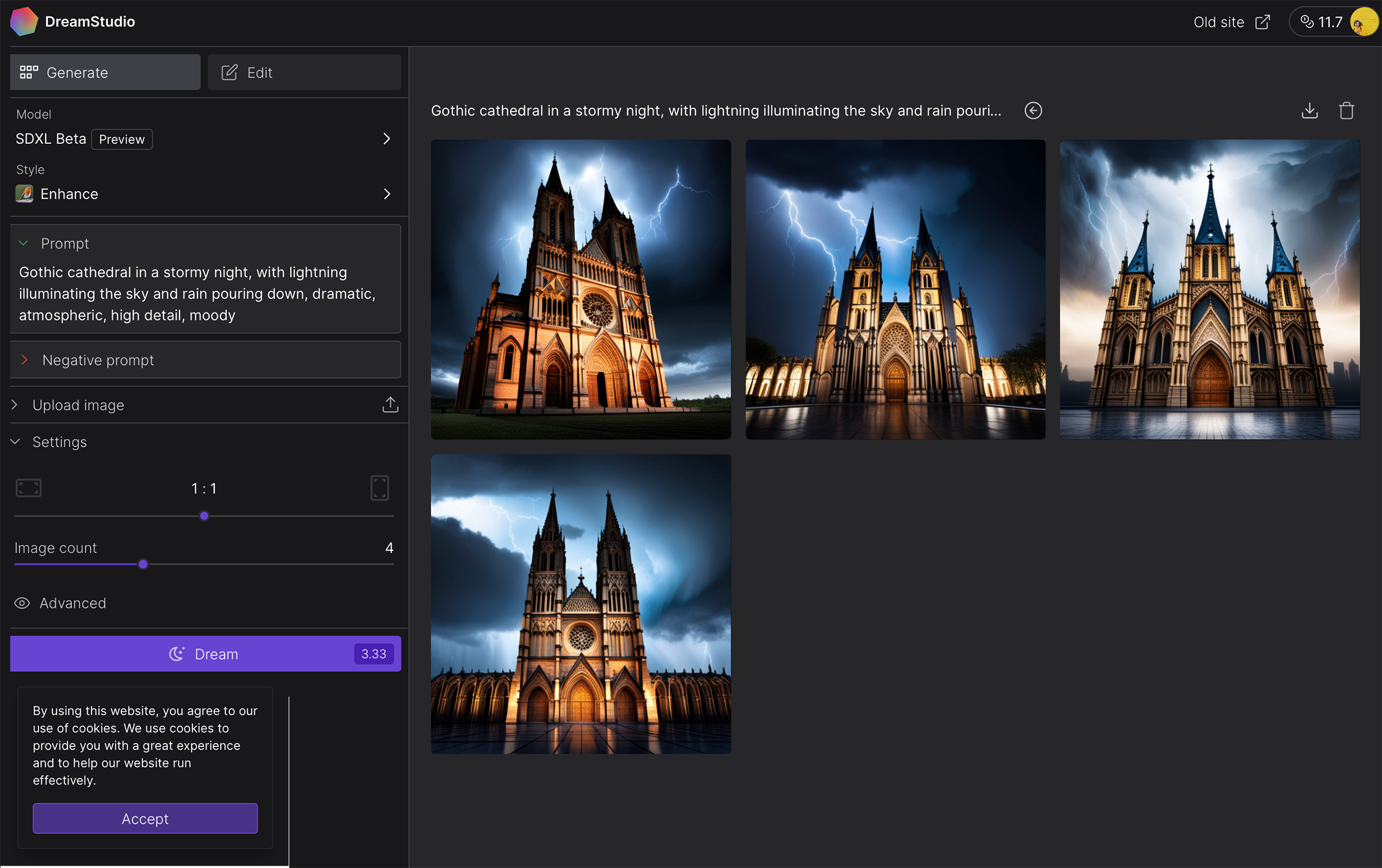

Dream Studio. Официальная облегченная версия Stable Diffusion, где можно выбрать одну из двух моделей. Бесплатно разрешается сгенерировать около 400 изображений — пока не закончатся кредиты. Тысяча кредитов стоит 10 $ (820 ₽). Этого хватит на генерацию четырех тысяч картинок. Требуется регистрация на сайте или логин в «Гугл» или «Дискорд».

После регистрации появляется окно, в котором генерируется изображение. Внизу нужно ввести запрос. Слева можно выбрать размер картинки и насколько сильно она должна соответствовать запросу. Максимальное количество шагов генерации — 150. Это означает, что столько шагов сделает нейросеть, пока будет генерировать изображение. За раз по умолчанию генерируется четыре картинки.

Google Collab. Это официальный сервис Google, где можно бесплатно запускать код на чужих вычислительных мощностях. Есть ограничения: при каждом запуске нужно ждать, пока загрузятся библиотеки и модели.

Откройте блокнот с одной из моделей SDXL, справа на странице нажмите «Подключиться», затем «Среда выполнения» — «Выполнить все». После этого начнется скачивание моделей — это занимает 5—10 минут. Когда оно завершится, пролистайте страницу с кодом до конца и нажмите на любую из ссылок.

Вы перейдете в веб-интерфейс Fooocus, которым пользуются те, кто устанавливает Stable Diffusion локально. Настроек множество: вы можете выбрать разрешение картинки, стили и скорость генерации. В интерфейс также встроен плагин ControlNet, который может генерировать изображения по контуру. Для этого нажмите Input Image → Image prompt в режиме Advanced → PyraCanny.

Сервис полностью бесплатный. Количество генераций ограничено только периодом, на который выдается доступ к нейросети — несколько часов. После того как срок истечет, вы можете загрузить модель заново.

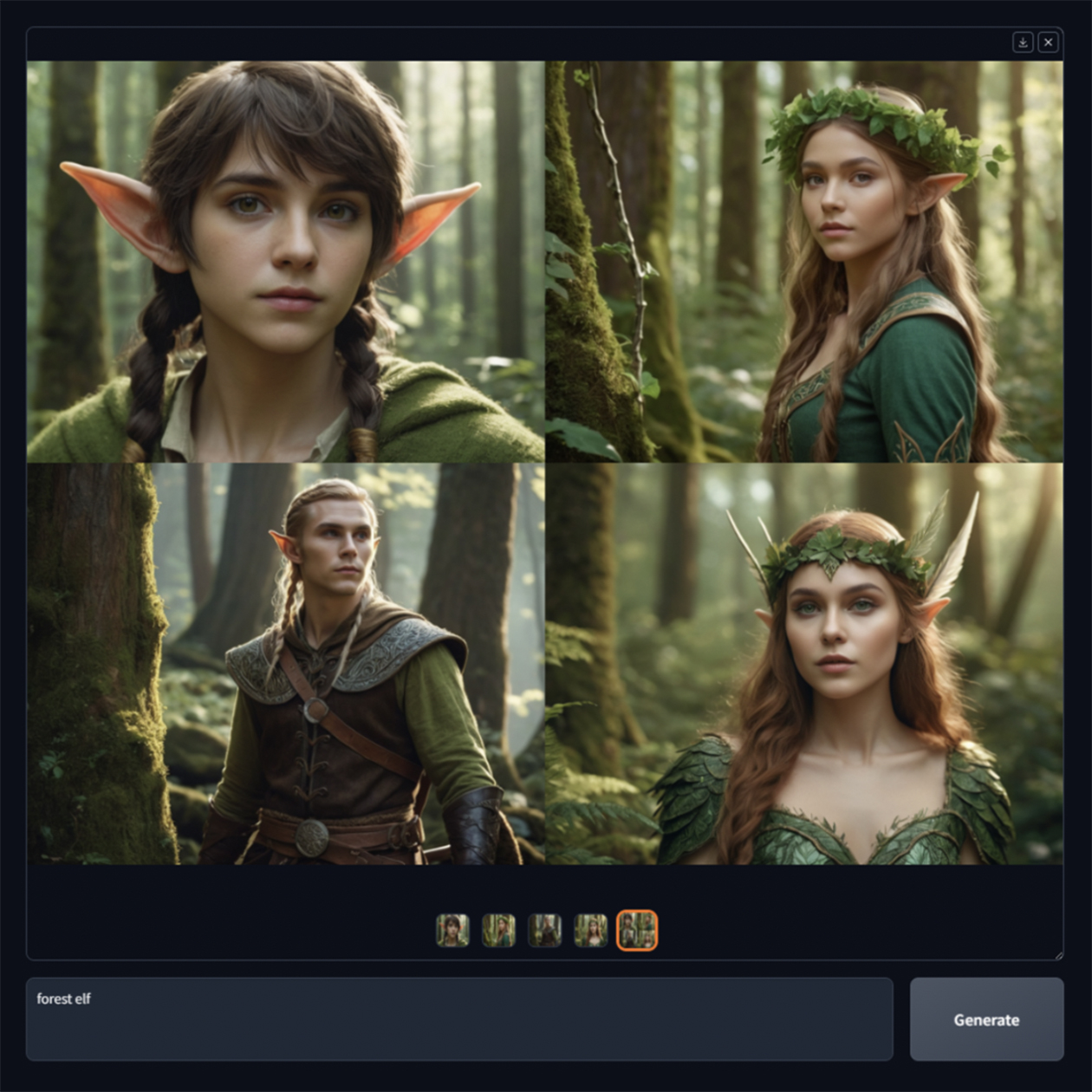

HuggingFace. На этой платформе пользователи публикуют разные модели Stable Diffusion, которые можно попробовать онлайн в один клик. Выбираете нужную, пишете запрос и нажимаете Generate. Сервис бесплатный, а количество генераций неограниченно. Настройки, как правило, менять нельзя.

Mage.Space. Самый простой в использовании — переходите на сайт и сразу вводите запрос без регистрации. Использует версию SDXL, поэтому генерирует хорошо. Бесплатный и безлимитный. Ограничение в 25 или 50 шагов генерации. После регистрации сгенерированные картинки сохраняются в галерею. Есть продвинутый режим с дополнительными настройками.

PlaygroundAi. Практически соцсеть — можно подписываться на других пользователей и смотреть их сгенерированные картинки в своей ленте. Бесплатный и безлимитный. Нет цензуры. Доступны три версии: 1,5, 2,1 и SDXL. Требуется авторизация через «Гугл». Максимальное число шагов генерации — 150. Можно выбрать размер изображения, добавить фильтр и сгенерировать четыре картинки сразу. Доступна генерация не только по текстовому запросу, но и по изображению.

👩💻 Как скачать программу со Stable Diffusion на ПК

Чтобы программа заработала, вам потребуется компьютер на Windows или Linux с видеокартой с объемом памяти 4 или 8 Гб. Это минимальные требования — чем мощнее ресурсы, тем быстрее будут генерироваться изображения. Если у вас MacOS, потребуется версия системы не старше 12.3, а у устройства должен быть процессор М1 или М2.

В сообществе Stable Diffusion такие программы называют форками, forks. Вот несколько установщиков, которые поддерживаются авторами. Инструкция по установке подробно описана на GitHub для каждого форка.

Fooocus. Одна из самых популярных оболочек для Stable Diffusion. Разработчик намеренно упростил интерфейс и приблизил его к опыту использования Midjourney. По запросу одновременно генерируется четыре картинки, из которых можно выбрать лучшую.

Еще одна особенность программы — стили. Если нажать на кнопку Advanced, можно выбрать уже подготовленные запросы. Среди них — аниме, изометрия, поп-арт, low-poly и десятки других. Нельзя выбрать точное разрешение или добавить расширения, зато подойдет новичкам, которые хотят сразу генерировать.

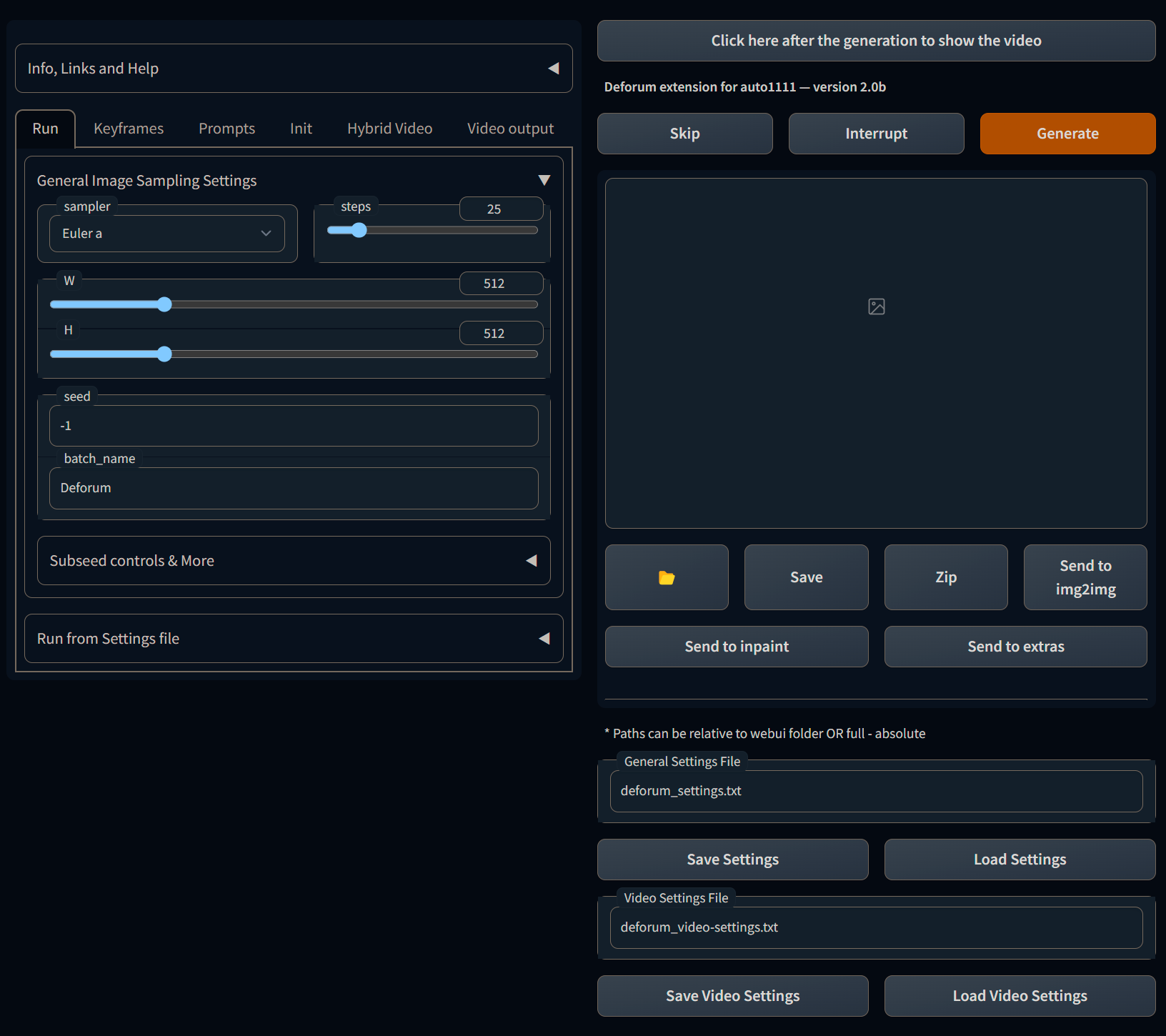

A1111. Простой способ установить самую популярную оболочку на Windows. Достаточно скачать лаунчер с GitHub, запустить его и пройти путь установки. Он установит базовую модель Stable Diffusion, дополнительные модели придется скачивать и добавлять самостоятельно.

Оболочка предоставляет самые полные настройки и свободу действий. Есть другая и более удобная версия этой программы — Forge. В ней разработчик ускорил генерации, добавил ControlNet и еще несколько расширений. Также она доступна на MacOS.

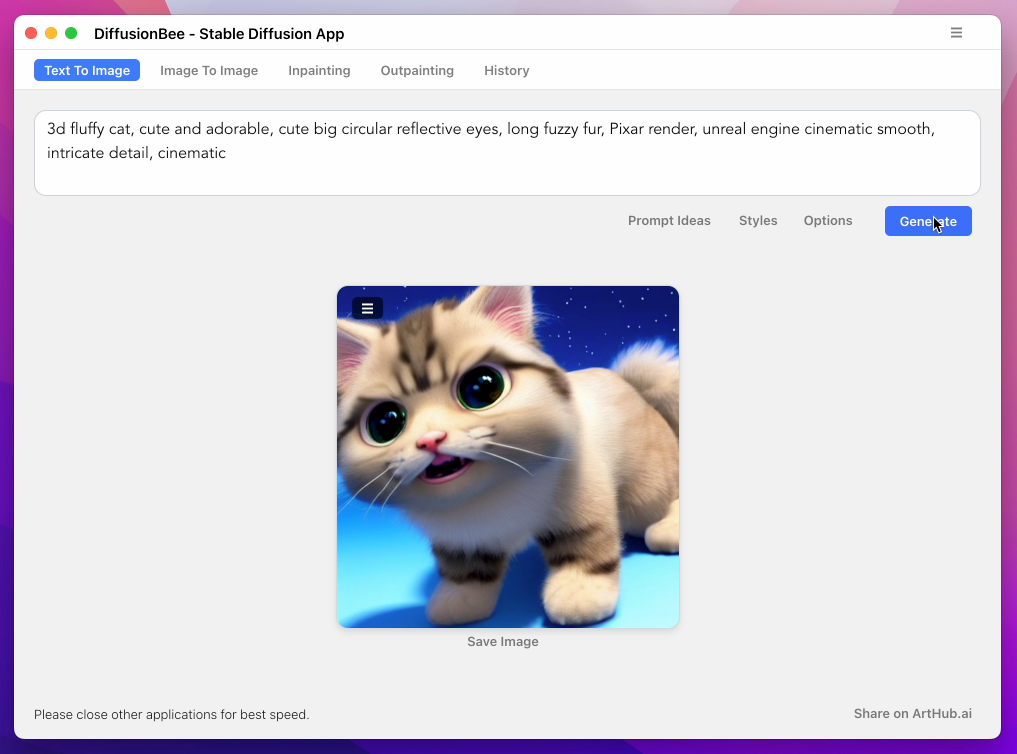

Diffusion Bee. Самый простой способ загрузить программу на MacOS. Достаточно скачать установочный файл и запустить программу. Практически не занимает места на жестком диске — всего 274 Мб.

У программы чистый и понятный интерфейс — можно сразу ввести запрос и получить результат. Есть пять разделов: для текстовых запросов, запросов по картинкам, генерации внутри картинки, генерации фона вокруг картинки, с историей запросов. Diffusion Bee может увеличить качество изображения. Есть фильтры на NSFW и остальной контент, запрещенный лицензией Stable Diffusion.

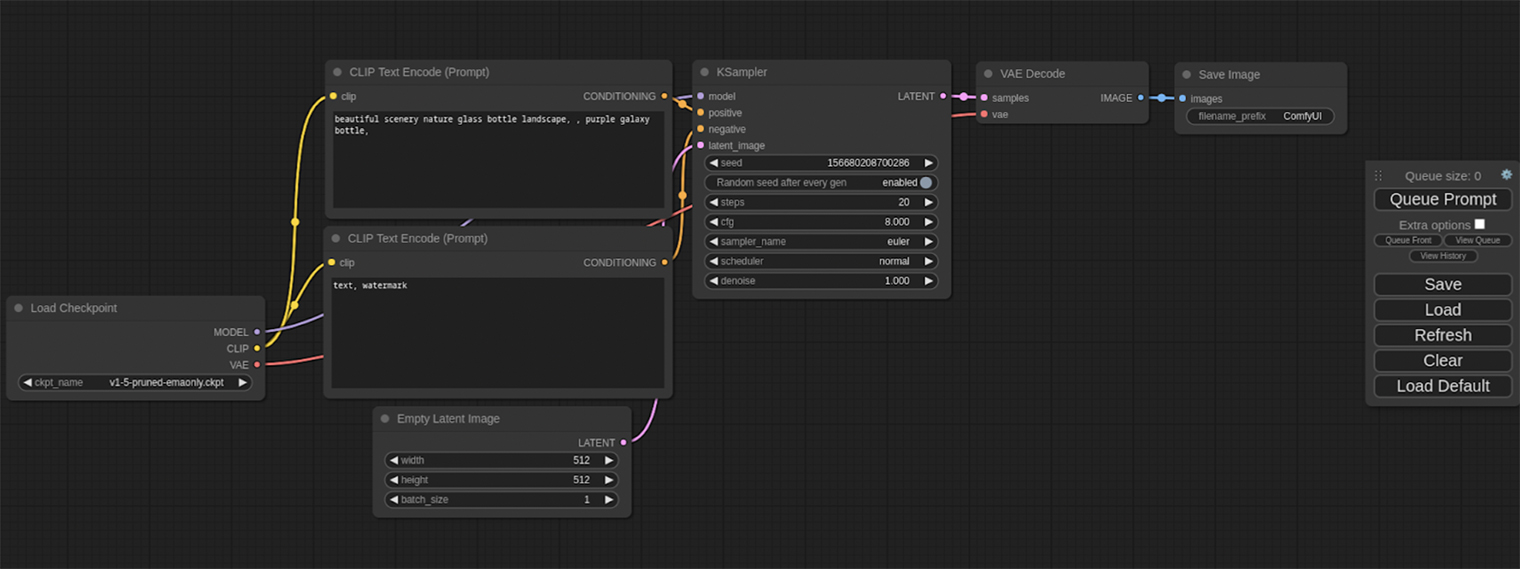

СomfyUI. Оболочка, которую рекомендуют StabilityAI. Она использует систему, похожую на 3D-редакторы наподобие Blender и Hoidini. Это помогает создавать собственные рабочие процессы.

Подойдет тем, кто готов разбираться в сложном интерфейсе.

🙊 Как составить запрос в Stable Diffusion

Если вы уже пробовали Midjourney, можно применить те же умения составлять промпты к Stable Diffusion — мы подробно описывали, как это сделать. Только здесь нет команд с двумя тире вроде «--beta» и «--s», а также нельзя отделять части запроса двоеточиями «::» — тут используется запятая.

Что означают настройки в генераторах Stable Diffusion

Steps — сколько шагов нейросеть сделает, пока генерирует изображение. Чем больше шагов, тем качественнее должен быть результат, а значит, тем больше времени уйдет на обработку запроса. По умолчанию ставится 50 шагов.

Classifier Free Guidance — этот параметр влияет на интерпретацию запроса, контрастность и детали. По умолчанию ставится 7. При параметре 3 можно получить больше реализма, но потерять в насыщенности и контрасте.

Seed — стартовый шум, из которого нейросеть затем формирует изображение. По умолчанию стоит «случайный» параметр — это помогает достигать разных результатов при одном и том же запросе. А если вы используете конкретное номерное значение сида, то потом даже при смене запроса композиция картинки останется схожей. Всего сидов около 16 миллиардов.

Resolution — размер изображения. Чем больше, тем дольше будет длиться генерация. Stable Diffusion 1.5 обучен на картинках 512 × 512, поэтому генерирует изображения такого разрешения лучше всего. Для версии SDXL лучше выбирать 1024 × 1024.

Sampler — методы обработки шума, которые влияют на результат генерации. С одними картинки можно генерировать за 8 шагов, другие требуют 50—80 шагов. Принцип работы сэмплеров на сгенерированных картинках можно посмотреть здесь.

Если вам не хочется вникать в настройки, попробуйте такую комбинацию для моделей SDXL: CFG — 4, Steps — 30, Sampler — DPM++ 2M Karras.

Несколько советов для составления запроса.

Придумайте идею. Стандартный запрос составляется по такой схеме: объект, фон, стиль, дополнительные описания качества картинки, освещения и других характеристик. Например, cat on the street, night city, purple lighting, film photo — кот на улице, ночной город, фиолетовое освещение, снято на пленку.

Следите за порядком слов. Он имеет значение. Stable Diffusion придаст больший вес первым словам, но может пропустить то, что вы указали в конце. Вы можете перемещать части своего запроса и получать кардинально разные результаты. Например, если вас не устраивает качество человеческого лица, перенесите его описание ближе к началу.

Распределите «вес». «Вес» каждого элемента запроса можно указать вручную: например, в DreamStudio его указывают после двоеточия со значением от 0 до 100. Получается вот так: red:50, green:50. В веб-интерфейсах для этого используют другую запись: (red:1.5) и (green:0.1).

Будьте многословны. Чем подробнее вы опишете свой запрос, тем лучше будет результат. Арты, неотличимые от созданных людьми, часто имеют около пяти-семи строк текста в запросе. Например, если хотите высокой детализации, добавляйте «highly intricate, ultra-detailed, 4k» и имена художников, рисующих в похожих стилях. Можно прописывать в запросе все сразу.

Используйте синонимы. Не бойтесь повторяться в запросах — так нейросеть попытается понять, к чему вы больше всего стремитесь. Например, если вы хотите передать мрачное настроение, то одновременно используйте слова «темно», «мрачно», «плохо освещено», «страшно», «хоррор».

Заимствуйте у других. С ходу придумывать запросы сложно, тем более так, чтобы результаты сразу получались качественными. Проще всего подсматривать запросы у других пользователей, чтобы искать вдохновление или нужные вам стилизации — для таких целей существуют сайты-промптеры. Совмещайте детали из разных запросов, удаляйте ненужное, добавляйте свое — так результаты будут получаться более разнообразными.

Пользуйтесь специализированными сервисами. Промптеры помогают составить идеальный запрос по выбранным критериям. Вот несколько полезных:

- Public Prompts — бесплатные запросы, разделенные по тематикам;

- PromptoMania — самый подробный промптер с кучей настроек, каждая из них проиллюстрирована;

- Lexica Art — крупнейшая галерея с бесплатными картинками и их описаниями, откуда можно копировать отдельные части запроса; есть поиск — например, по запросу cyberpunk показывает более 1200 результатов;

- OpenArt — галерея, аналогичная Lexica Art, картинки можно смешивать или добавлять в закладки.

Главное — не переживайте, если у вас с нескольких попыток не получается желаемого результата. Чтобы нейросеть угадала, что вы имели в виду, обычно приходится перебирать десять модификаций одного и того же запроса.

Что в итоге

- Stable Diffusion — мощная нейросеть, возможности которой сравнимы с Midjourney и Dall-E 3. В отличие от конкурентов, это бесплатный проект с открытым исходным кодом, поэтому возможностями алгоритма может пользоваться любой и даже разворачивать его на своем ПК.

- Чтобы установить «чистую» версию Stable Diffusion, нужны навыки программирования. Но уже есть сервисы на базе нейросети: они гораздо проще в освоении и включают все функции.

- Можно генерировать картинки на сайте и в приложениях, но мы советуем Google Collab — он позволяет запускать Stable Diffusion через чужие вычислительные мощности на любых устройствах.

- Составление текстового запроса в Stable Diffusion работает по тому же принципу, что и в других нейросетях: указываете объект, затем стилистику и дополнительные параметры. Не можете придумать сами — пользуйтесь специализированными сервисами.

Генерировали картинки в нейросетях? Поделитесь своими результатами и расскажите, какой запрос использовали