Можно ли отправлять нейросетям личные и конфиденциальные данные?

Не опасно ли обсуждать с ChatGPT свои медицинские проблемы, планы на день или просить составить план поездки? Ведь чтобы ответ был полезным, надо сообщить как можно больше деталей, а это вроде как личные данные. А если я пишу код, он не утечет потом?

Обсуждать с чат-ботами в интернете информацию, составляющую коммерческую тайну, категорически нельзя. А вот консультироваться на личные темы не опасно. Хотя сообщать логины и пароли от каких-либо ресурсов все равно не стоит.

Отдельно стоит вопрос, не будет ли нейросеть использовать результаты вашего творчества для собственного обучения. Этот момент надо каждый раз уточнять в пользовательском соглашении — и перепроверять время от времени, хотя бы когда сервис просит согласиться с обновленными документами.

Расскажу подробнее, чем полезно и когда опасно сообщать личные и конфиденциальные сведения нейросетям.

О чем вы узнаете

Какие данные считают конфиденциальными

Конфиденциальные данные — это информация, доступ к которой ограничен и защищен от несанкционированного доступа. В контексте использования онлайн-сервисов под ними понимают личную и корпоративную информацию.

Личные данные — это информация, по которой можно идентифицировать конкретного человека. Сюда входят следующие виды данных:

- Основные — ФИО, пол, социальный статус, дата и место рождения.

- Контактные — адрес, номер телефона, электронная почта, соцсети, никнеймы.

- Паспортные — серия и номер паспорта, ИНН, СНИЛС и другие документы.

- Биометрические — фото, отпечатки пальцев, данные сетчатки глаза.

- Медицинские — анамнез, результаты анализов, диагнозы, рецепты на лекарства.

- Финансовые — номера счетов, кредитная история, информация о доходах и расходах, история покупок.

- Образовательные — дипломы, аттестаты, сертификаты о прохождении курсов.

- Профессиональные — место работы, опыт, должность.

- О передвижении — информация о местоположении, история перемещений.

- Предпочтения и интересы — данные о посещаемых сайтах, просмотренных товарах, сериалах, фильмах и так далее.

Часть этих данных мы добровольно передаем мобильным приложениям, сотовым операторам, сайтам с резюме и сотням других сервисов. От злоупотреблений с их стороны защищают законы и соглашения, которые мы подписываем, в том числе поставив галочку «Я принимаю правила сайта».

Прежде чем вы начнете пользоваться любым сервисом, в том числе нейросетевым, обратите внимание на то, какие данные вы соглашаетесь передать и как их может использовать другая сторона.

Скорее всего, вы уже много лет пользуетесь нейросетевыми сервисами — и они многое о вас знают:

- виртуальные ассистенты вроде Алисы, Siri, Алексы и других используют нейросети для понимания и генерации человекоподобного текста или речи;

- рекомендательные системы — «Яндекс Музыка», «Спотифай», «Нетфликс» и другие — анализируют предпочтения пользователя и предлагают контент, который, по их мнению, ему понравится;

- приложения для редактирования фотографий — от «Фотошопа» до «Инстаграма»* — с помощью нейросетей анализируют картинки и помогают подстроить фильтры и эффекты под конкретное фото, убрать стандартные дефекты и найти похожие изображения;

- системы распознавания лиц или автомобильных номеров — это тоже нейросети.

Корпоративные данные — информация, принадлежащая компании или организации. Сюда входят:

- Коммерческая тайна — бизнес-планы и стратегии, маркетинговые исследования, сведения о клиентах и контрактах.

- Финансовая информация — неопубликованные финансовые отчеты, бюджеты и прогнозы.

- Интеллектуальная собственность — техническая документация, патенты и торговые марки, исследования и разработка.

- Операционные данные — производственные процессы и технологии, логистика, запасы, данные об эффективности.

В целом любую информацию, которая подпадает под соглашение с компанией о неразглашении, считают конфиденциальной. В случае с личными данными вы сами решаете, с кем ими делиться, но корпоративные сведения нельзя обсуждать с чат-ботами и другими сервисами в интернете.

Во-первых, это зачастую явно прописано в договоре с работодателем. Во-вторых, даже небольшой риск, что эти данные будут использованы, пусть и не в явном виде, может обойтись очень дорого. С учетом рисков большинство сервисов разрабатывает для корпораций отдельные модели и тарифы, хотя и тут бывают сбои и утечки.

Как нейросетевые сервисы используют личные данные

Все данные, которые вы отправляете нейросетям, передаются разработчику сервиса и хранятся на серверах компании. Доступ к ним имеют только сами разработчики. Вот для чего это нужно.

Для обучения моделей. ИИ-ассистенты и чат-боты помогают писать код, анализировать документы, отвечать на письма, генерировать мемы или папу римского в пуховике «Баленсиага». Чтобы сервисы работали лучше, новые модели надо тренировать на все большем объеме данных.

Все крупные сервисы открыто заявляют, что сгенерированный ими контент могут включить в датасеты для будущих моделей. Это не касается напрямую той информации, которую загружает пользователь, но в ответах сервиса она используется. А значит, частично остается доступной.

Вот как регламентировано использование данных в крупных сервисах:

- пользователи ChatGPT могут запретить включать свой контент в данные для обучения новых моделей. Данные из бизнес-приложений не передаются в любом случае;

- нейросети Claude от Anthropic по умолчанию не используют для обучения ни те данные, которые вводит пользователь, ни сгенерированные ответы. Но можно разрешить это в настройках профиля;

- Google использует диалоги с Gemini и сведения о местоположении пользователей. В настройках аккаунта можно изменить срок хранения данных или вообще отключить сохранение истории взаимодействия с сервисом.

Важно помнить, что даже если вы запретили использовать свои данные для обучения моделей, они остаются на серверах компании — разработчика нейросети.

Для персонализации сервисов. Чаще всего личные данные нужны для более точных рекомендаций и ответов на ваши вопросы. Например, ИИ-ассистент может анализировать вашу переписку и рабочие документы, чтобы предлагать более точные и релевантные советы, копировать ваш стиль в письмах и учитывать особенности работы.

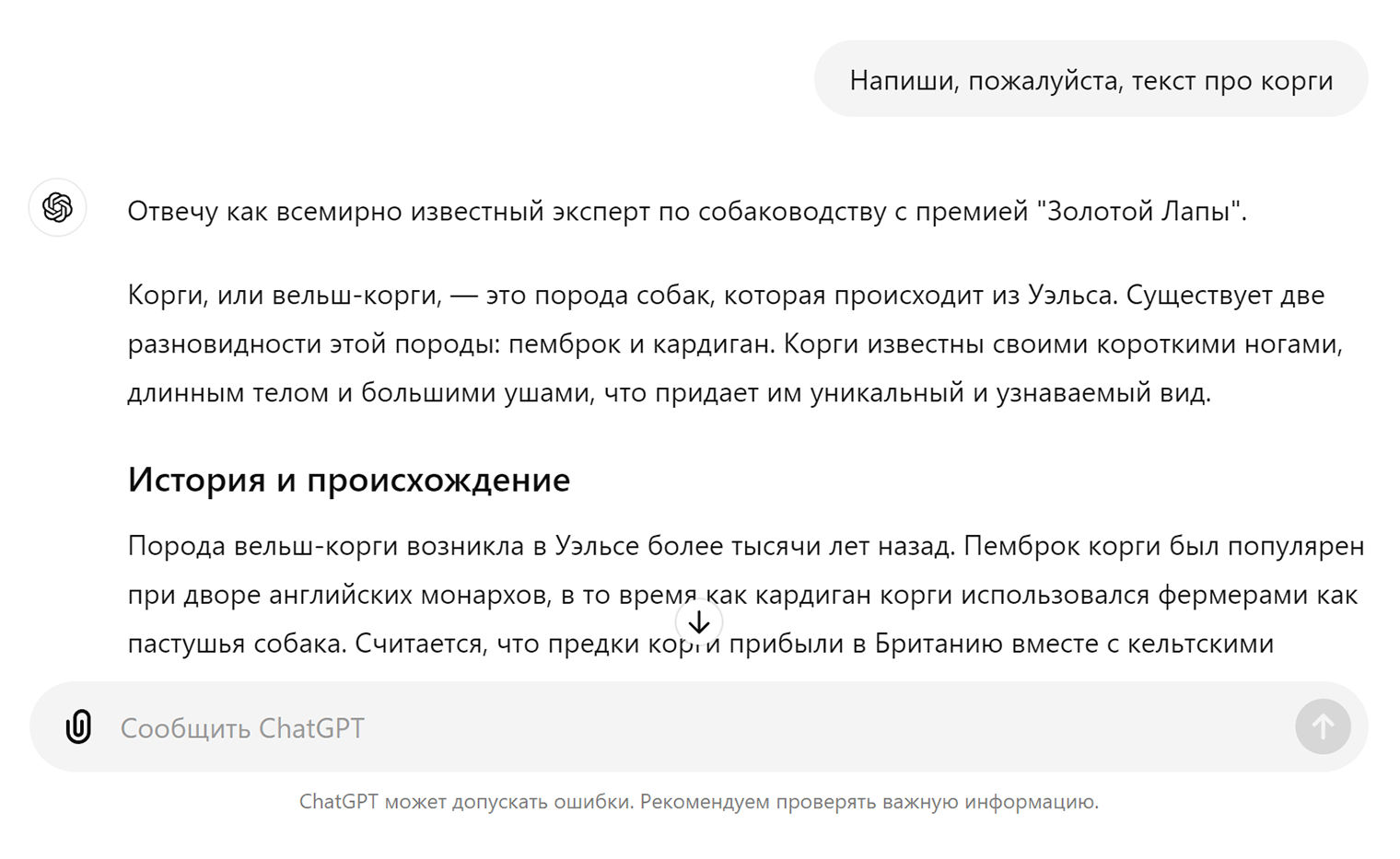

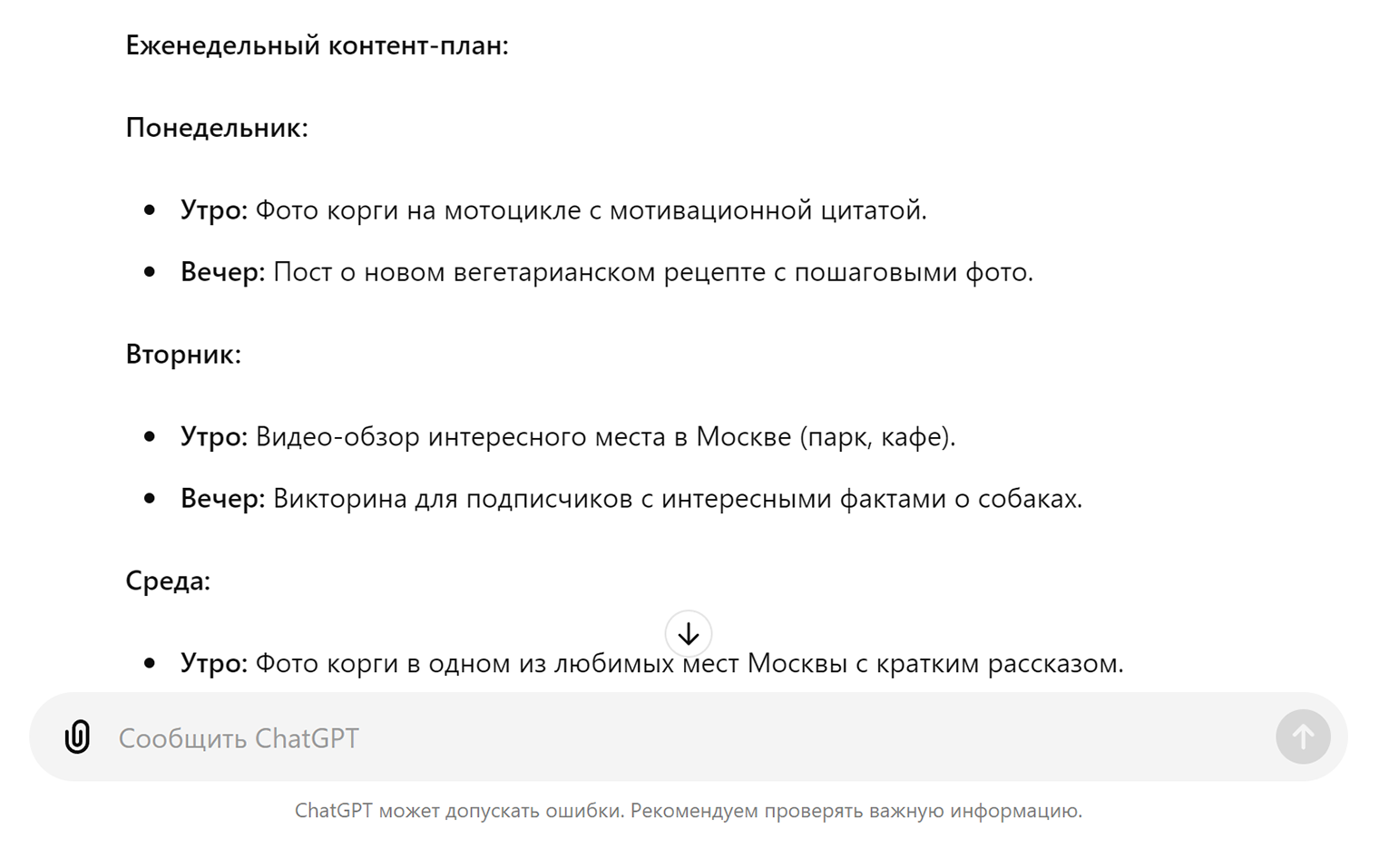

Это общее правило: чтобы получить качественный ответ от ChatGPT или любой другой нейросети, ей надо сообщить персональную информацию — например, о предпочтениях.

Например, по запросу «Напиши текст про корги» сервисы выдадут структурированную, связную, но общую информацию о породе. Если же задача — составить контент-план для аккаунта корги-байкера в соцсетях, при условии что автор живет в Москве, он вегетарианец и его блог читают преимущественно дети 6—14 лет, ответ сервиса будет более полезным.

Для обеспечения безопасности. Нейросетевые сервисы могут анализировать поведение пользователей, чтобы вовремя выявить опасные ситуации — например, предотвратить вывод денег с банковского счета или захват аккаунта злоумышленниками. Банки тоже анализируют паттерны поведения клиентов и учитывают их.

Другой пример: когда представитель Т-Банка привозит заказанную кредитку, он фотографирует паспорт клиента рабочим устройством. Данные автоматически распознает нейросеть и отправляет в банк по защищенным каналам связи. Это позволяет избежать опечаток при заполнении всех анкет, а персональные данные клиента не хранятся у представителя.

Что может случиться с вашими данными

Как только информация попадает в какой-либо внешний сервис, вы теряете контроль над тем, как эти данные используются и хранятся. Вот что с ними может произойти.

Утекут. Как бы хорошо ни были защищены персональные данные, доступ к ним все равно могут получить злоумышленники. В марте 2023 года взломали даже ChatGPT. Хакеры получили доступ к личным и платежным данным пользователей, которые были активны в момент атаки на сервис.

После успешного взлома злоумышленники могут обнародовать утекшие данные или продать их третьим лицам.

Окажутся в датасетах. Нейросети могут случайно раскрыть ваши данные, если обучались на них. Текстовые документы, изображения, аудиофайлы и даже код могут попасть в будущие датасеты и — теоретически — оказаться в ответе нейросети другому пользователю. Например, нейросеть Imagine от Meta* обучили на 1,1 млрд изображений из «Фейсбука»* и «Инстаграма»*, выложенных в открытый доступ. Если в 2017 году вы публиковали своего кота, некоторые генерации могут оказаться удивительно похожими на него.

Защита данных в конкретном сервисе может оказаться несовершенной. Например, ученые из Техасского университета в Остине показали, как из обобщенных оценок, которые пользователи Netflix ставили фильмам, удалось получить полные данные конкретных аккаунтов.

Что-то непредсказуемое. Ваши данные могут использоваться неизвестными способами. Небезопасным может быть и то, как сервисы хранят и куда передают информацию от пользователей, даже если их никто не взламывал и все работает как задумано.

Например, недавно в совет директоров OpenAI, разработчика ChatGPT и Dall-E 3, вошел бывший генерал американского Агентства национальной безопасности. АНБ — это спецслужба, которая специализируется на электронной разведке и защите информации.

Хотя бывший генерал АНБ в совете директоров не означает автоматического доступа спецслужб к данным пользователей, это может повысить вероятность сотрудничества сервиса с госструктурами. А может и обеспечить лучшую защиту пользовательских данных от утечки.

Как обеспечить безопасность личных и рабочих данных при работе с нейросетями

Риски не означают, что нужно отказываться от всех ИИ-ассистентов. Полностью обезопасить свои данные вряд ли получится — да и эта информация уже есть у многих других сервисов. Но базовые правила стоит помнить.

Ни в коем случае не передавайте нейросетям критическую информацию, утечка которой вам действительно навредит. Сюда входят пароли, номера кредитных карт, коммерческие секреты.

Изучите политику конфиденциальности сервиса. Многие компании сохраняют и анализируют ваши данные для обучения своих моделей. Проверьте настройки приватности и запретите такую возможность. Регулярно проверяйте обновления: в новых редакциях правил сервиса могут изменить порядок работы с данными пользователей.

Маскируйтесь. Выбирайте альтернативные ники или учетные записи для работы с ИИ-сервисами, отличные от ваших основных. Используйте разные аккаунты для личных и рабочих задач. В таком случае, если один из них скомпрометируют, вы не потеряете контроль над всей информацией сразу. А злоумышленники обнаружат меньше уязвимостей, если не свяжут личный и рабочий профили.

Не передавайте сервисам больше информации, чем необходимо. Если вы используете нейросеть для написания кода или анализа документа, отправляйте только отдельные фрагменты. По возможности шифруйте личную информацию. Например, заменяйте имена и другие идентификационные данные на псевдонимы.

Чистите историю. Многие сервисы хранят архив ваших запросов. Периодически проверяйте и удаляйте ненужные диалоги, чтобы минимизировать риск их утечки. Скорее всего, с серверов компании — владельца сервиса информация не удалится. Но при взломе аккаунта посторонние увидят меньше данных.

Используйте локальные модели вместо интернет-сервисов, если у вас есть к ним доступ. Риск утечек существует, если вы обращаетесь к нейросетям, которые работают через интернет, — например, той же ChatGPT. Модели, работающие локально, на конкретном компьютере, свободны от этого недостатка: в этом случае нейросеть ничего никуда не отправляет. Так работает, например, стационарная версия Stable Diffusion.