Как распознать дипфейк и защититься от обмана

В конце сентября 2024 года прошла вторая конференция журнала.

Я рассказал, как нас обманывают с помощью современных технологий, а потом ответил на вопросы слушателей. Выступление продлилось почти полчаса. Ключевые идеи — в этой статье.

Вы узнаете

Как нас обманывают с помощью дипфейков

С помощью нейросетей кто угодно может сделать виртуальную копию голоса или изображения человека. Такую копию называют дипфейком.

Еще в 2022 году для создания более-менее правдоподобного дипфейка требовались качественные видео- или аудиозаписи. Затем нейросеть приходилось десятки часов обучать и тренировать, чтобы она выдала минутный дипфейк.

В 2023 мы с командой подкаста «Схема» решили ради эксперимента сделать дипфейк моего голоса. У нас было восемь часов студийных записей и команда опытных программистов. Им пришлось арендовать мощный сервер, потратить почти сотню долларов и десять часов на обучение нейросети. В итоге получился роботизированный голос с явным английским акцентом: хороших русскоязычных моделей тогда не было. Результат можно послушать в восьмом выпуске второго сезона.

Мы пришли к выводу, что массовые дипфейки на русском появятся нескоро. И обычному человеку они не грозят, ведь для их обучения нужны часы аудио и видео студийного качества — мало у кого они есть в свободном доступе.

Мы ошиблись. Прошло всего полгода — и появились нейросети, которым достаточно буквально 15 секунд видео или аудио со смартфона, чтобы сделать цифрового двойника человека. Конечно же, этим воспользовались мошенники: они адаптировали старые схемы, чтобы сделать их более реалистичными.

Вот несколько популярных схем разводов, которые прокачали с помощью нейросетей.

«Дай в долг до завтра, это точно я». Этой схеме более 20 лет: первые хакеры взламывали ICQ и рассылали по всему контакт-листу просьбы одолжить вебмани или пополнить счет телефона. Затем так же взламывали другие мессенджеры и соцсети.

За десятилетия эта схема стала известна почти всем, ее высмеивают в скетчах и анекдотах. Мошенники поняли, что простым текстом никого не обмануть. Поэтому сейчас, взломав кого-нибудь, они ищут голосовые или видеосообщения. Затем «скармливают» их нейросети — и та выдает дипфейк.

Теперь друзья получают не скучный текст, а реалистичную просьбу голосом взломанного человека. Даже те, кто знает о схеме со взломом, считают, что запись сделал реальный собеседник, — и переводят деньги мошенникам.

Если хотите убедиться, что знакомого не взломали, попросите его что-то сделать на камеру. Скажем, встать и помахать руками перед лицом. Злоумышленник воспротивится: ведь он не сможет оперативно сделать реалистичный дипфейк по вашему запросу. Настоящий собеседник поймет ваше беспокойство и выполнит просьбу.

Если подозрения остались, свяжитесь с человеком лично, желательно по телефону или видеосвязи.

«Помоги победить в конкурсе». Хакеры не всегда просят денег. Порой им нужно что-то невинное: скажем, проголосовать в конкурсе. Но ссылка ведет на фишинговый сайт, где мошенники попытаются получить доступ к вашему мессенджеру или аккаунту в соцсети.

В случае успеха они будут искать что-то, чем можно шантажировать владельца аккаунта: например, интимные фотографии. Параллельно они поищут пароли от онлайн-банков и госуслуг: многие хранят их в заметках или в переписке с самим собой. А если успеют, сделают дипфейки с вами и разошлют вашим знакомым просьбы одолжить денег.

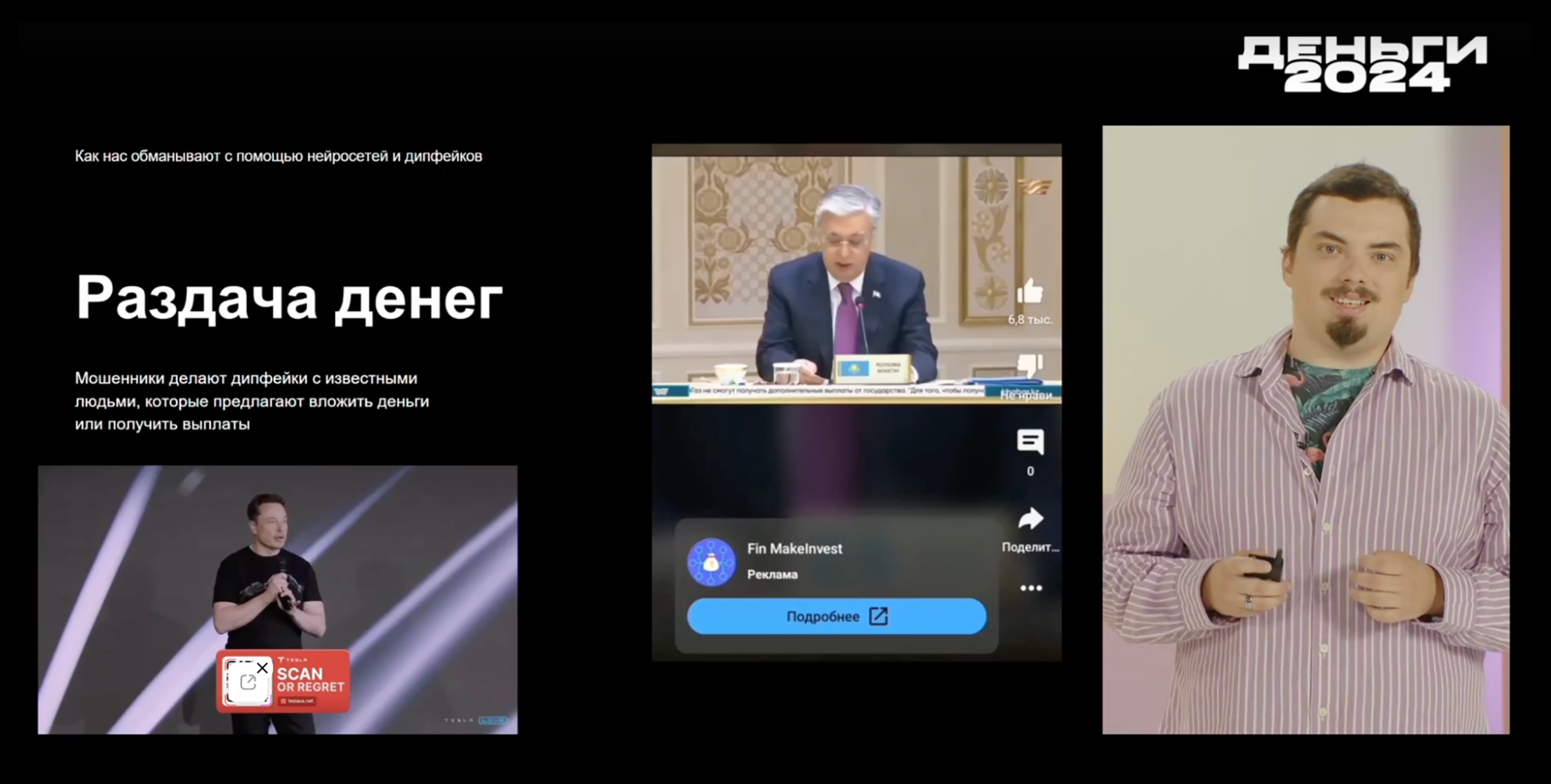

«Привет, я известный человек и дарю вам много денег». Чтобы сделать дипфейк знаменитости или политика, их даже не нужно взламывать: в сети легко найти сотни часов качественных видеозаписей с их участием.

В итоге рано или поздно вы наткнетесь на рекламу, где президент страны обещает выплатить вам часть доходов от продажи полезных ископаемых — если уплатите «налог». Или известный предприниматель объявит, что ему надоело быть богатым и он хочет поделиться деньгами с народом: достаточно отправить на специальный счет криптовалюту, а в ответ он пришлет в два раза больше.

Как распознать дипфейк

Лучше всего нейросети распознают другие нейросети. Например, банки давно используют нейросетевые технологии для анализа речи. Поэтому у меня вызывает смех популярный миф, что нельзя отвечать «да», если вам звонят с незнакомого номера. Мол, мошенники запишут голос, позвонят от вашего имени в банк, включат запись и каким-то образом украдут все деньги.

Банковские технологии защиты все вычислят, мошенникам не поможет даже качественный дипфейк голоса или лица. Такая «добрая» нейросеть называется liveness: она в режиме реального времени проверяет голос и видео человека по тысяче параметров. Например, анализирует, как он улыбается, поворачивает голову, щурит глаза, жестикулирует. Оценивает скорость реакции, движение мимических мышц и дефекты изображения: блики, рябь, размытие лица. Подробнее о том, как работают liveness, я рассказал в отдельной статье.

А вот простым людям пока что приходится вычислять дипфейки буквально на глаз. Вот несколько моментов, на которые стоит обращать внимание в первую очередь.

Артефакты изображения. Человек редко и медленно моргает, а движения губ не совсем совпадают с тем, что он говорит. Лицо излишне замыленное или пикселизированное. Засветы или слишком сильные тени, заметные различия тона кожи на лице, руках и шее.

Кадрирование. Чересчур приближенное изображение лица, толком не видно даже шею. Неестественное положение головы.

Проблемы с голосом. Он слишком монотонный или немного роботизированный. Неверные ударения и частые паузы. Излишне короткие фразы. Непривычные для человека выражения и манера общения.

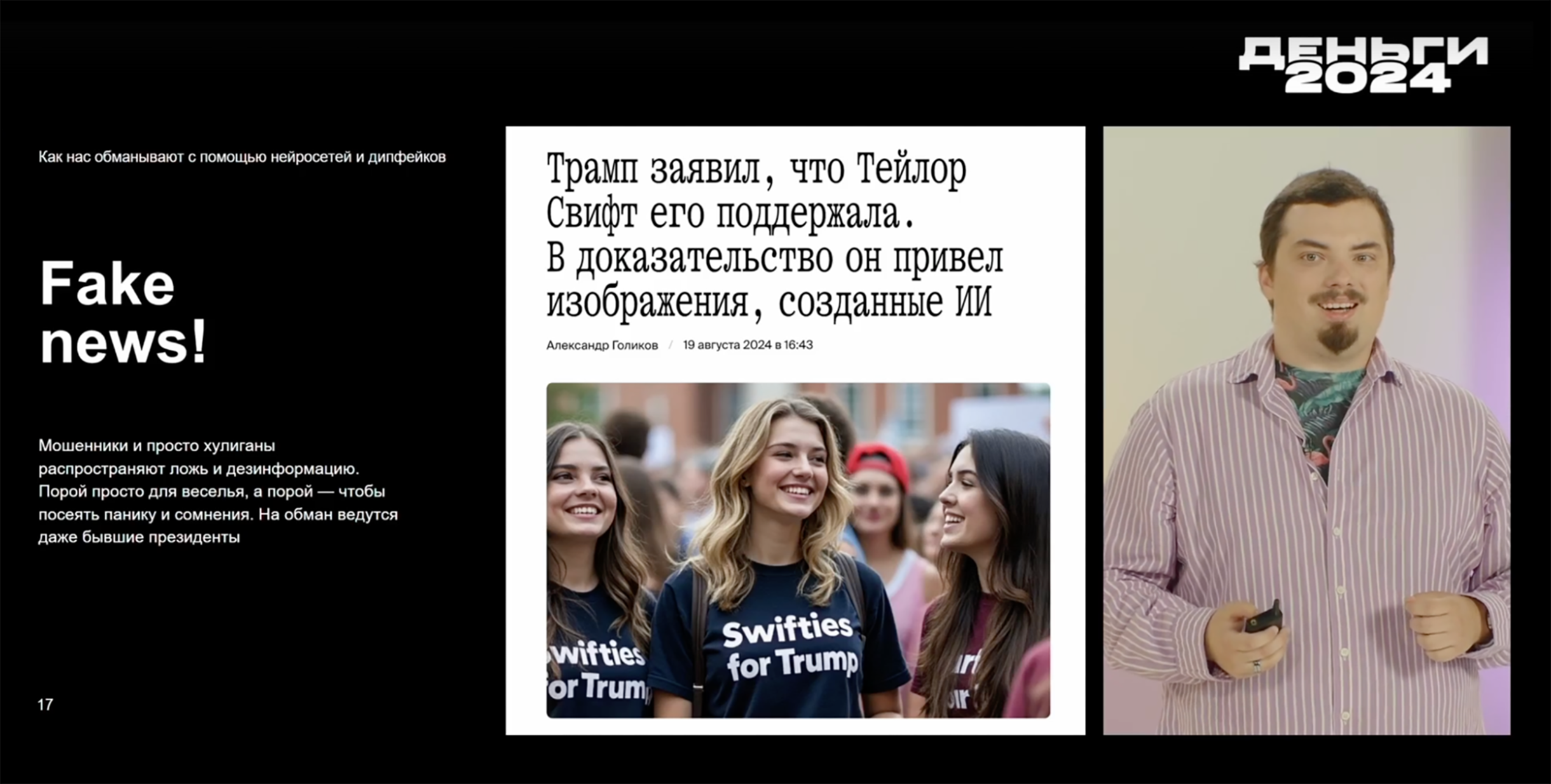

Как распознать фейковые новости

С появлением нейросетей аферистам стало намного проще массово обманывать людей. Иногда они это делают просто веселья ради: например, генерируют фото Папы Римского в модном пуховике и рассылают его в информагентства. Но чаще мошенникам нужны деньги: после землетрясений в Турции жулики генерировали жалостливые картинки с пожарными, которые вытаскивают детей из-под завалов, и призывали жертвовать криптовалюту.

Вот несколько простых способов, которые помогут распознать обман.

Присмотритесь к фото. Сгенерированное изображение выдают странные руки, размытая линия роста волос, неровный контур лица, разный цвет глаз и их странная посадка, чересчур асимметричное лицо, плохо прорисованные или слишком белые зубы, искаженные аксессуары. Нейросетевые пейзажи и объекты часто выглядят слишком красочно. На портретах — только лицо, словно это фото на пропуск.

Задумайтесь, на какие чувства давит заголовок. Если он вызывает страх, шок, ненависть и желание тут же поделиться новостью, возможно, вами пытаются манипулировать.

Поищите информацию в других источниках. Если это резонансное событие, о нем наверняка напишут крупные СМИ. Они обычно указывают, откуда получили сведения.

Если новость разлетелась только по анонимным телеграм-каналам, а в крупных СМИ ничего подобного нет — скорее всего, причина не в том, что «власти замалчивают» или «есть секретная темка заработать». Вероятно, вас просто хотят обмануть.

Как мошенники автоматизируют схемы разводов

Нейросетевые чат-боты упростили работу мошенникам. Если раньше им приходилось вручную общаться с потенциальными жертвами, чтобы уговорить вложиться в криптовалюту, то теперь все можно поручить ChatGPT.

Это сильно расширило «воронку продаж» мошенников. На первом этапе чат-боты массово спамят в мессенджеры, завязывают разговоры на сайтах знакомств, оставляют комментарии в соцсетях. Если человек продолжает общение, то нейросеть дает сигнал мошенникам — и к разговору уже подключается живой оператор.

Если незнакомец пишет вам что-то похожее, скорее всего, вы общаетесь с нейросетью:

Если сталкивались с мошенниками, поделитесь своей историей с другими читателями