«Эпл» будет искать запрещенный контент в фотографиях пользователей

«Эпл» объявила, что внедрит в 2021 году в iMessage меры по защите детей от неприемлемого контента.

Кроме того, Айфоны и Айпады научатся автоматически находить среди фотографий пользователей, загружаемых в Айклауд, неприемлемый контент и сообщать о нем корпорации. А та уже передаст информацию в правоохранительные органы.

Под неприемлемым контентом в этом случае подразумеваются материалы, которые обозначаются аббревиатурой CSAM: child sexual abuse material — дословно «материалы с сексуальной эксплуатацией детей». Проще говоря, речь о детском порно и фотографиях сексуального характера с участием детей.

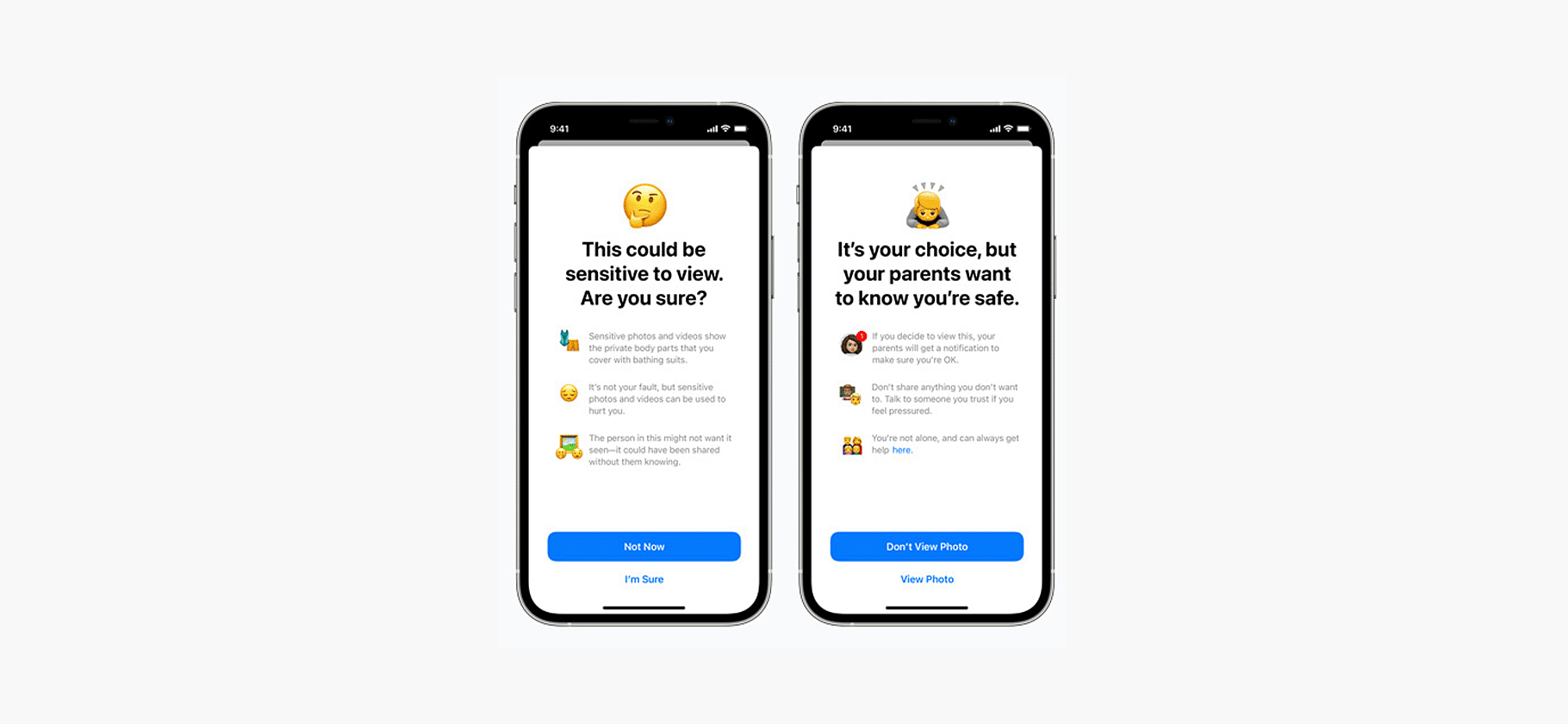

Защита детей в iMessage

Это нововведение касается детей, которые используют технику «Эпл» с настроенным семейным доступом, то есть когда родители или опекуны со своих устройств могут накладывать ограничения на их действия.

Гаджеты детей с помощью машинного обучения будут анализировать фотографии, которые им присылают в приложении «Сообщения», которое объединяет в себе iMessage и обычные смс. Если алгоритм найдет на фотографии обнаженного человека, «Сообщения» скроют изображение и предупредят об этом ребенка. Он все еще сможет посмотреть снимок, но тогда его родители получат уведомление об этом.

Если ребенок сам попытается отправить фотографию, на которой алгоритм найдет обнаженную натуру, «Сообщения» попросят его подумать дважды. А если он все же решит это сделать, уведомят его родителей.

«Эпл» подчеркивает, что сама корпорация никакой информации об этих фотографиях получать не будет.

Поиск запрещенных фото на устройствах

Перед тем как мы перейдем к подробностям работы механизма сканирования фотографий, несколько важных примечаний:

- Это нововведение и предыдущее пока будут внедряться только для пользователей в США, хотя в дальнейшем «Эпл» может распространить их и на остальной мир.

- Речь не идет об анализе содержания собственных фотографий пользователей: система будет только выяснять, нет ли среди них снимков из базы фотографий сексуального характера с участием детей.

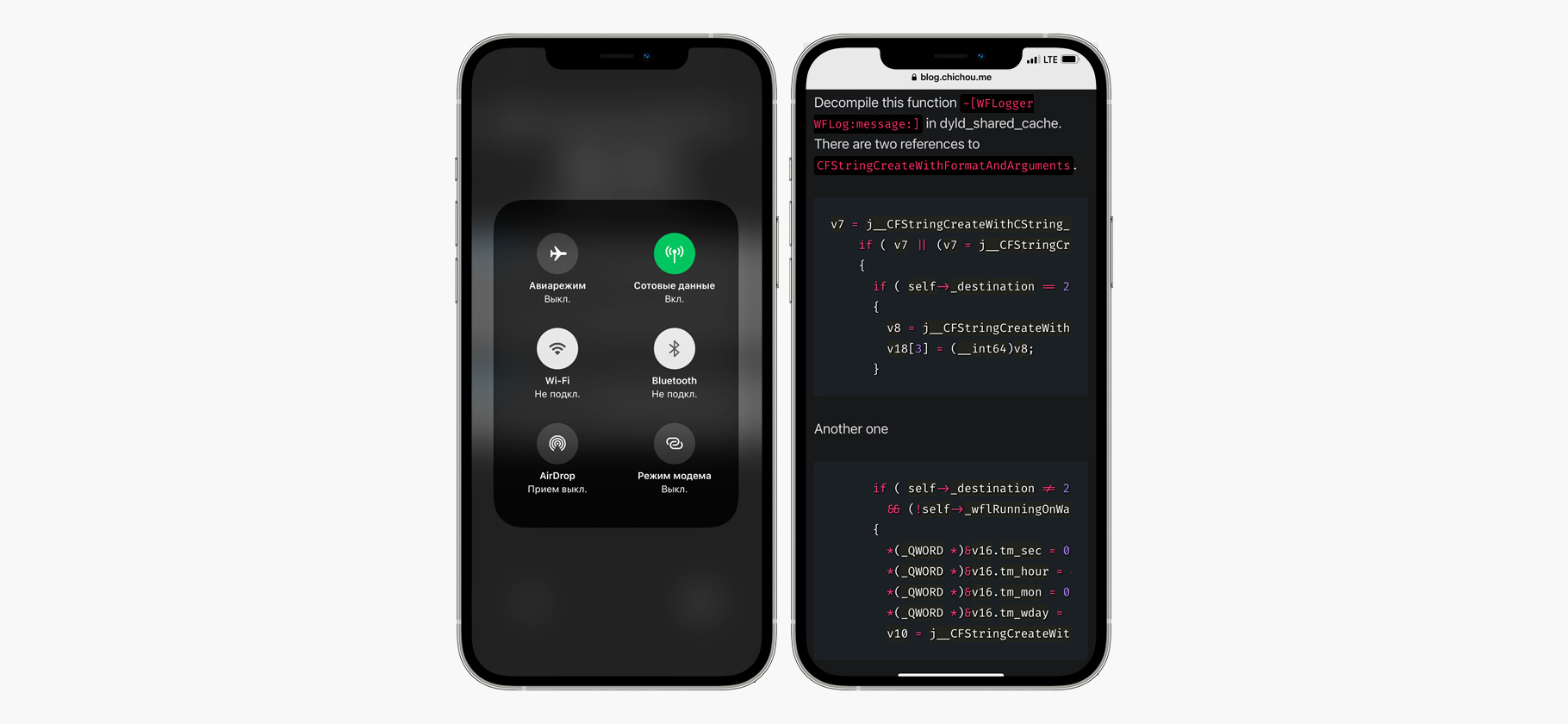

- Фотографии будут сканироваться при загрузке в Айклауд — если отказаться от облачного хранилища, то и анализа, по идее, можно избежать.

- Если система найдет достаточно большое количество запрещенных фотографий, их передадут сотруднику «Эпл», а тот после ручного анализа перешлет данные NCMEC — Национальному центру поиска пропавших и эксплуатируемых детей, который сотрудничает с правоохранительными органами.

- Узнать, сколько запрещенных фото нашла система, пользователь не сможет. Если их будет достаточно много, его аккаунт заблокируют, но он сможет подать апелляцию.

Теперь разберемся, как это работает. Все начинается с базы изображений, признанных детским порно, которую собирает NCMEC и другие организации. «Эпл» получает не сами изображения, а их хэши — специально сгенерированные строки, которые будут одинаковыми для одинаковых изображений и разными для разных.

Особенность хэшей в том, что по ним невозможно восстановить исходный файл, но можно сравнить хэши двух файлов между собой. Причем алгоритм, который применяется в этом процессе, устойчив к манипуляциям с фотографиями: даже если изменить цвета и размер или обрезать снимок, его хэш будет таким же, как у исходного фото.

Таблица таких хэшей хранится на устройствах пользователей, но в зашифрованном виде. «Эпл» применяет криптографические методы, обеспечивающие двойную защиту: Айфон или Айпад пользователя может сравнить хэши его личных фотографий с хэшами из базы детского порно, но не может узнать результаты этого сравнения. Следовательно, не узнает их и сам пользователь. А «Эпл» при дальнейшем анализе в Айклауде сможет расшифровать сведения только о тех фотографиях, чей хэш совпал с хэшем из базы запрещенного контента.

Чтобы этот анализ произошел, устройства пользователей станут вместе с самими фотографиями загружать в Айклауд ваучеры безопасности — в них будет храниться хэш фотографии и ее визуальная производная. «Эпл» не объясняет, что это за производная, но, вероятно, это фрагмент снимка или его обработанная версия, которую на финальных этапах анализа будет рассматривать сотрудник компании.

В ваучерах безопасности также будут храниться фрагменты специального ключа шифрования, который сгенерирован на устройстве и изначально неизвестен «Эплу». Этим ключом зашифрованы хэш и визуальная производная, причем чтобы расшифровать данные, нужно получить несколько фрагментов такого ключа.

Идея вот в чем: одного совпадения хэша из галереи пользователя с хэшем из базы детского порно недостаточно, чтобы делать однозначные выводы. Поэтому «Эпл» устанавливает некое минимальное количество совпадений, необходимое, чтобы дать делу ход. Это количество неизвестно, но до тех пор, пока оно не будет достигнуто, в распоряжении «Эпл» окажется недостаточно фрагментов ключа для расшифровки содержимого ваучеров безопасности.

Как только нужное число фрагментов будет собрано, корпорация сможет расшифровать все ваучеры безопасности фотографий из базы детского порно — но только их, не остальных фото пользователя — отправить их на ручную проверку модератору и при необходимости передать информацию в NCMEC, сотрудничающему с правоохранительными органами.

Грозит ли это чем-то обычным пользователям

Зависит от дальнейших действий, а также от дальнейших действий «Эпл» и властей. Прямо сейчас система выглядит как безусловное благо: она позволит выявлять людей, которые по какой-то причине хранят на своих телефонах большое количество фотографий, признанных детским порно.

С другой стороны, существующий механизм гипотетически можно использовать, чтобы находить в коллекциях пользователей и другие виды запрещенного — или неугодного властям — контента.

Криптограф Мэтью Грин, преподающий в университете Джонса Хопкинса, написал, что такой механизм в будущем может стать «ключевым компонентом для системы слежки за защищенными средствами связи». Он также опасается, что алгоритм хэширования может оказаться уязвимым для атак, когда специально сгенерированное изображение будет иметь такой же хэш, как и фотография из запрещенной базы.

И Мэтью Грин, и журналисты The Verge, писавшие о нововведениях «Эпл», особенно опасаются, что новый механизм заинтересует власти Китая, которые пытаются получить как можно более широкий доступ к данным местных пользователей Айфонов.

Что говорит «Эпл» в ответ критикам

Через несколько дней после анонса «Эпл» опубликовала документ с ответами на часто задаваемые вопросы о нововведениях, касающихся защиты детей и борьбы с распространением детской порнографии.

В этом документе компания объясняет, что детекция обнаженных фото в «Сообщениях» и поиск детской порнографии среди снимков, выгружаемых в iCloud, — это две разные технологии, не связанные друг с другом. Так, первая технология работает целиком на устройстве несовершеннолетнего пользователя, добавленного в семейную группу, и только если родители включат эту функцию.

При этом родители получат уведомление о том, что ребенок получил или отправил неприемлемое фото, только если он не достиг 13 лет. Подростки от 13 до 17 лет тоже увидят предупреждение об обнаруженной «обнаженке», но уведомление родителям отправлено не будет.

Технология анализа фотографий пользователей на наличие в них детского порно, подчеркивает «Эпл», работает только со снимками, выгружаемыми в Айклауд. Если отключить синхронизацию с облаком, личные снимки пользователей сканироваться не будут.

Шанс ошибочного обвинения невинных людей в хранении детского порно крайне низок, подчеркивает компания, в том числе благодаря тому, что перед тем, как предпринять какие-то действия, она передаст подозрительные снимки на анализ модераторам.

Наконец, один из вопросов звучит так: «Смогут ли власти заставить „Эпл“ добавить в список хэшей, по которым ведется сравнение, изображения, не являющиеся детской порнографией?» Компания ответила, что будет отклонять любые такие требования, и отметила, что технология разрабатывалась исключительно для борьбы с детским порно.