ChatGPT получил новую модель o1: что умеет нейросеть, которая научилась «сложным рассуждениям»

12 сентября OpenAI представила новые улучшенные модели для чат-бота.

Компания показала две версии — o1-preview и o1-mini. Особенность в том, что они уделяют больше времени размышлениям перед тем, как дать ответ. Из-за этого ответы получаются более качественными и продуманными. Это нужно в первую очередь для того, чтобы решать сложные математические и научные задачи. Но и в обычной жизни «рассуждающая» нейросеть пригодится.

Расскажу, что умеют новые модели, чем отличаются от предыдущих и как их попробовать.

Что такое o1

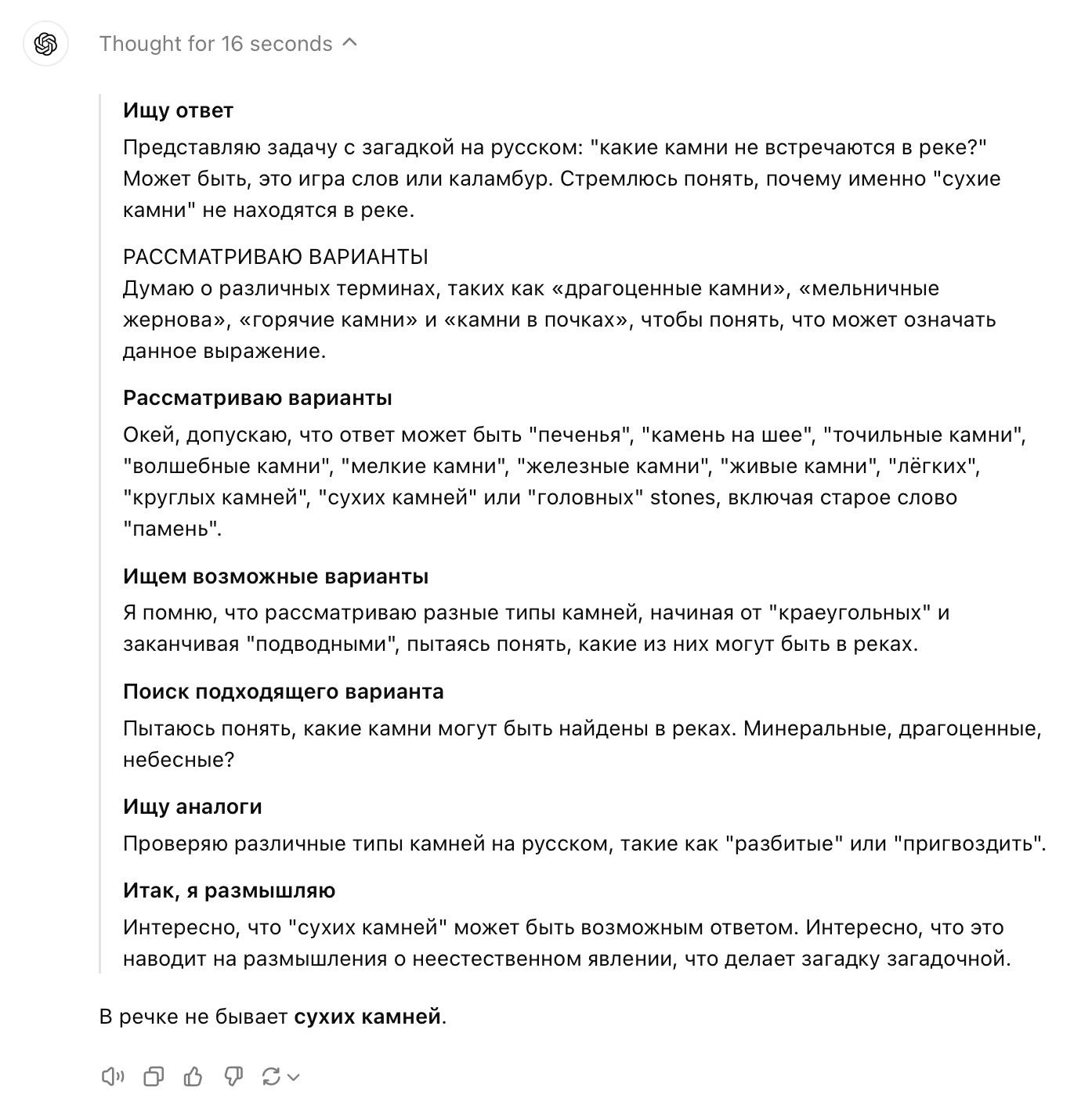

Версии o1 — это большие языковые модели, обученные с помощью метода с подкреплением . Они тщательно обдумывают решение перед тем, как ответить. Из-за этого нейросеть реагирует медленнее, зато сразу формирует цепочку размышлений — подобно тому, как люди поэтапно решают сложные задачи. Это позволяет o1 не только давать более точные ответы, но и увереннее аргументировать их.

Новая модель с рассуждениями реализует давний «костыль» ChatGPT. Пользователи чат-бота выяснили, что, если заставить нейросеть «думать пошагово», это улучшает ответы и повышает производительность. Но этот эффект достигался за счет специальных промптов, которые подобрало сообщество. Теперь o1 не нужно просить думать комплексно, она делает это автоматически.

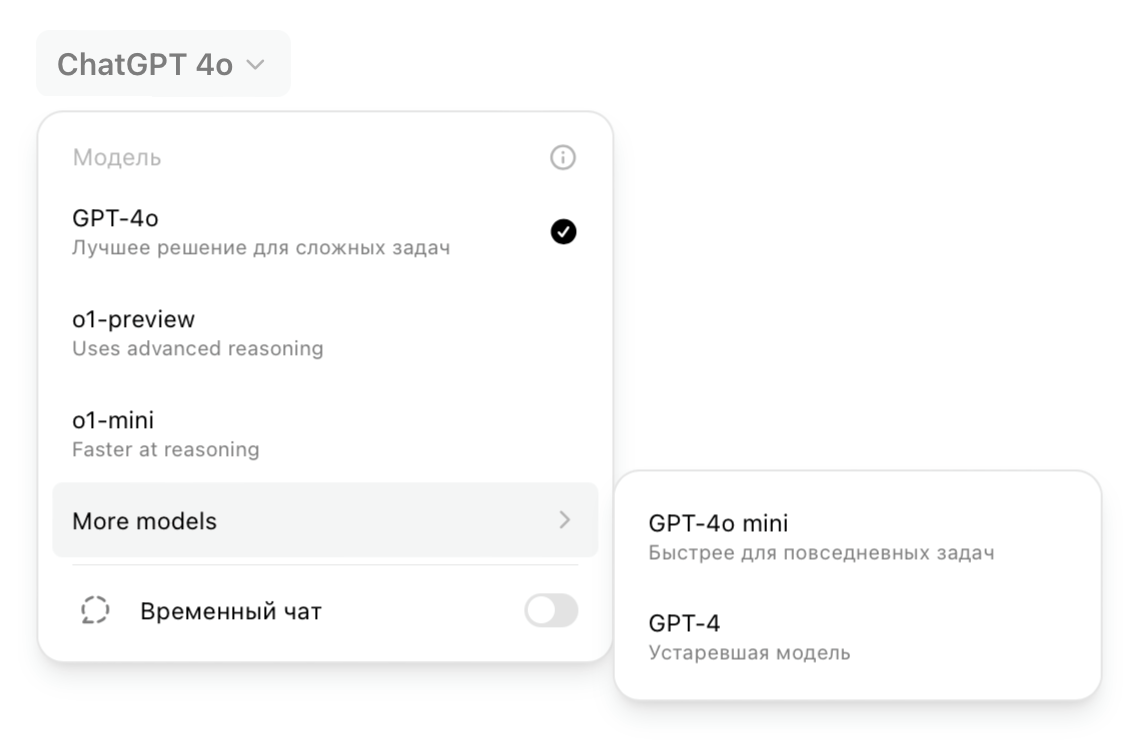

В ChatGPT доступно две версии:

- o1-preview — ранняя версия модели o1 для решения сложных задач с использованием широких общих знаний о мире.

- o1-mini — более быстрая версия o1 для задач в программировании, математике и науках, где не требуется обширная общая информация.

В OpenAI отмечают, что o1 не заменит предыдущую модель GPT-4o во всех сценариях. С базовыми запросами эффективнее справляется GPT-4o, так как у нее более обширные знания о мире. Предполагается, что пользователи будут использовать разные модели под разные задачи.

Кроме того, o1 пока не поддерживает распознавание изображений, поиск в интернете, возможность загружать файлы и запускать код. Это обещают добавить в будущем.

Чем отличается o1

Версии o1 принципиально не превосходят модели уровня GPT-4, но есть несколько важных особенностей. Вот что они умеют.

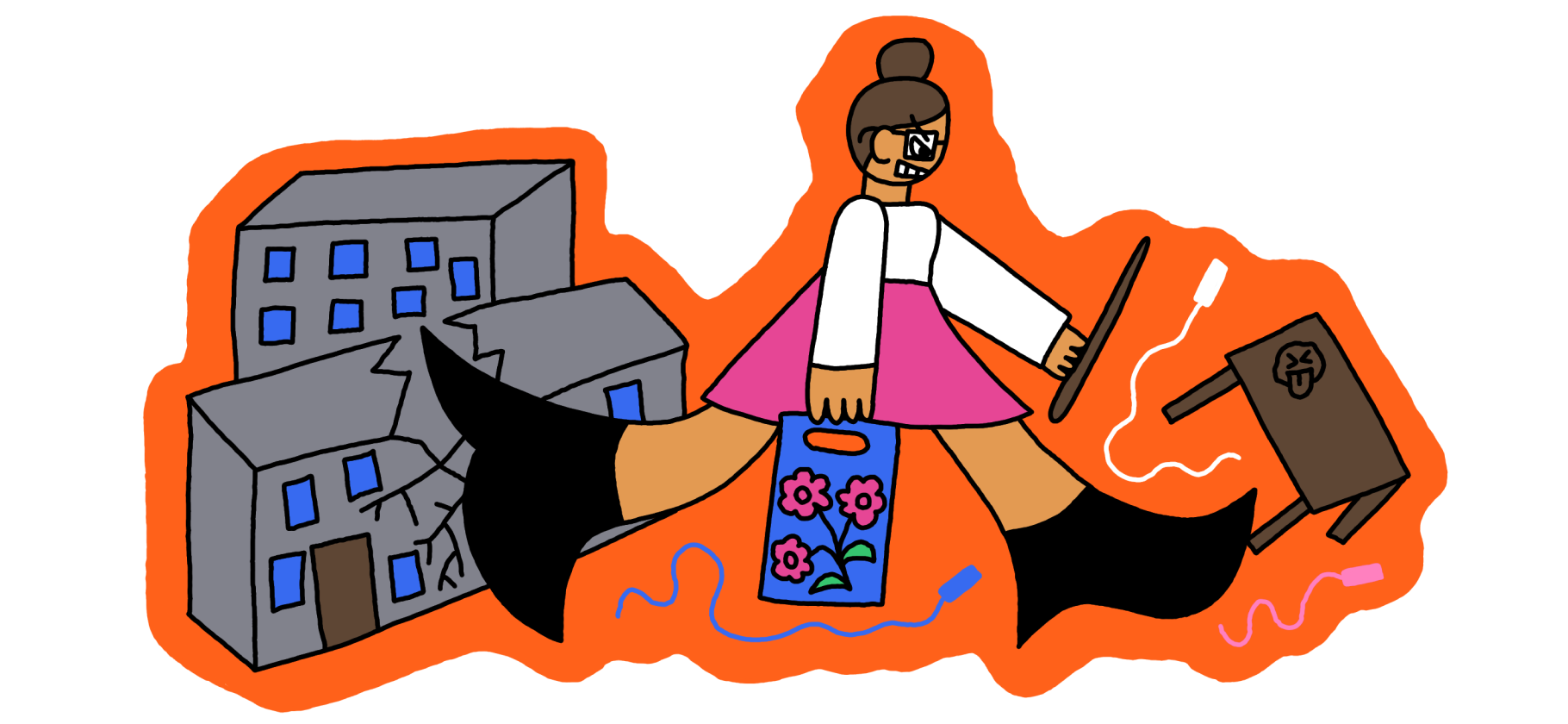

Рассуждать «как человек». Модели o1 выстраивают длинную внутреннюю цепочку размышлений перед тем, как дать ответ. Для этого нейросеть разбивает запрос на части, чтобы лучше его понять, и рассматривает несколько вариантов ответа.

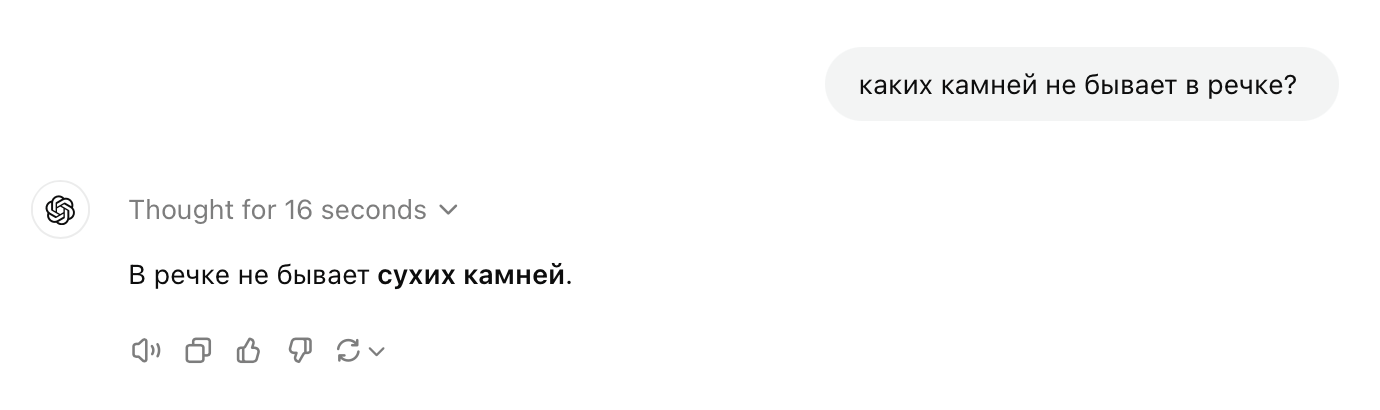

Пользователи, попробовавшие o1, отмечают, что она справляется с загадками на логику, которые все остальные модели разгадать не могли.

Брать время на размышление. Новая модель генерирует ответ в течение 10—20 секунд и только потом показывает его пользователю. Предыдущие модели выдают слово за словом, из-за чего случаются ошибки. По задумке, новая технология снизит количество галлюцинаций .

Решать сложные задачи — научные, программистские и математические. По данным OpenAI, в тестах по физике, химии и биологии модели отвечали на уровне аспирантов. В отборочном туре Международной математической олимпиады, IMO, GPT-4o правильно решила 13% заданий, а новая модель — 83%. Пользователи уже убедились, что модель справляется со школьными задачами по физике лучше других.

OpenAI, например, предлагает врачам-исследователям аннотировать с помощью o1 данные секвенирования, а физикам — выводить формулы в квантовой оптике. Разработчикам модель поможет написать сложный код.

Как писать запросы для o1

OpenAI представила официальные советы по промптингу для o1. Вот что рекомендует компания.

Писать просто и понятно. Модели понимают короткие инструкции без подробных пояснений.

Избегать пошагового рассуждения. Поскольку модели и так выполняют этап с рассуждением, запросы с формулировками вроде «думай поэтапно» или «объясни свой ответ» не нужны. Они могут только испортить ответ.

Использовать разделители. Например, тройные кавычки, теги, заголовки раздела четко обозначат разные части запроса и помогут модели интерпретировать их.

Ограничить дополнительный контекст. Компания рекомендует включать только самую релевантную информацию, чтобы модель не усложняла ответ.

Как получить доступ к o1 и сколько она стоит

Доступ к o1-preview и o1-mini постепенно предоставляют платным подписчикам ChatGPT Plus с 12 сентября. Подписка стоит 20 $ (1824 ₽) в месяц, оплатить ее картой российского банка не получится.

Модели также доступны по API, но существенно дороже, чем предыдущие. К примеру, 1 млн токенов на ввод в o1-preview обойдутся в 15 $ (1368 ₽), а на вывод — в 60 $ (5472 ₽). GPT-4o в три раза дешевле.

Если у вас есть подписка ChatGPT Plus, то, чтобы включить o1, откройте новый чат, нажмите на меню с выбором модели и кликните на o1-preview или o1-mini. Будьте внимательны, у моделей жесткие лимиты: 30 сообщений в неделю для o1-preview и 50 для o1-mini.

В будущем все лимиты рассчитывают увеличить. В планах также открыть доступ к o1-mini всем бесплатным пользователям ChatGPT, но когда — неизвестно.

Мы постим кружочки, красивые карточки и новости о технологиях и поп-культуре в нашем телеграм-канале. Подписывайтесь, там классно: @t_technocult